Après une année 2011 très riche en actualités cybercriminelles, il apparait que les nouvelles attaques sont de plus en plus évoluées, de plus en plus ciblées afin d’atteindre des organisations spécifiques et de véhiculer des messages précis à caractère souvent idéologiques ou politiques. La motivation est le plus souvent le vol d’informations ou le désir de nuisance par le blocage ou le détournement du contenu des applications internet.

Le début de l’année a été marqué par les évènements du « Printemps Arabe » qui se sont accompagnés par des attaques contre des sites gouvernementaux et boursiers Tunisiens. Ensuite des institutions comme le FMI, Mastercard, Visa, Sony, PayPal et la CIA ont été prises pour cible. Le territoire Français n’a pas non plus été épargné avec des attaques telles que celles du ministère des finances en début d’année ou plus récemment du journal Charlie Hebdo. Dans cette dernière affaire, les contenus du site internet ont été substitués avec une facilité apparemment déconcertante avec la possibilité toute aussi évidente de reproduire l’attaque sur un autre site d’un autre journal qui pourrait leur venir en aide.

Je ne sais pas si toutes ces actualités ont éveillées chez les DSI ou les RSSI une quelconque inquiétude ? N’ont ils pas l’impression d’avancer en terrain miné avec un bandeau sur les yeux en se disant que la moindre désapprobation d’un groupe d’individus peut conduire à déclencher les foudres sur le système d’information.

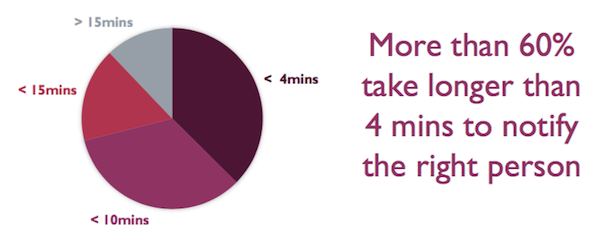

Ces nouveaux types d’attaque sont de plus en plus difficiles à identifier, et lorsqu’elles le sont, il est généralement trop tard. Les entreprises doivent donc être extrêmement rapides dans l’identification de ces agressions et efficaces de manière à les combattre et les enrayer dés le début.

N’est ce pas là ou souvent le bas blesse ? En effet, la protection du système d’information est une pièce qui se déroule en trois actes indissociables, à savoir la prévention, la détection et la réaction.

Si à l’heure actuelle, la partie préventive est relativement bien couverte dans les entreprises par le maintien à jour des systèmes de protection, des logiciels utilisés, ainsi que par une bonne sensibilisation des utilisateurs, la partie réactive semble un peu moins bien pourvue. Quel pourcentage de directions informatiques sont capables de détecter une intrusion avant que des dégâts ne soient visibles ?

A l’heure où l’informatique est présente partout, tout entrepreneur devrait être conscient qu’il puisse être victime de piratage ou de vol de données. L’enjeu est capital et peut causer des pertes financières importantes, des déficits d’image et de confiance de la part de la clientèle. Il convient donc de mettre en place les dispositifs de détection adéquate et de s’assurer qu’ils restent opérationnels au fil du temps.

Une étude récente de Verizon au cours de l’année 2011 souligne cette carence avec les chiffres suivants :

- 83% des attaques sont ciblées et dans 58% des cas elles proviennent de groupes organisés

- 86% des attaques ont été découvertes hors des organisations par un client ou un partenaire, et dans 46% des cas par détection d’une fraude

- 96% des attaques auraient pu être arrêtées par des contrôles simples et 69% d’entre elles ont laissé des preuves sous forme de traces dans les logs

Ces chiffres confirment l’incapacité des organisations à appréhender la phase de détection et par conséquence à ne pas déclencher la phase de réaction. Ce qui est le plus grave, c’est que dans cette inconscience aveugle des entreprises, ce sont les clients finaux qui souvent leur remontent les faits à postériori, souvent après le constat d’une fraude. Ce type de défaillance d’une entreprise, peut en plus du déficit d’image créé, entrainer des conséquences juridiques quant au manquement à la protection des données personnelles de ses clients.

Si l’enjeu est important, la difficulté l’est aussi, car il convient de traiter les alertes et les messages émis par de nombreux équipements, et tout ceci en temps réel. Néanmoins il existe des techniques regroupées sous le nom SIEM pour « Security Information and Event Management » capables de gérer des informations venant de sources multiples. Le principe est d’analyser tous les évènements issus des différents équipements et de les corréler afin de les rattacher à une même cause.

J’ai été, dés 2006, personnellement confronté à ce genre de problématique face à la réalisation d’un projet de remontées des alarmes de sécurité vers une console centralisée du « Security Operation Center » pour un des plus grands évènements sportifs internationaux et multi disciplines qui, cette année là, se tenait à Turin, en Italie.

Dans ce cadre, le système d’information avait la charge de gérer les aspects logistiques de transport, de réservations, les systèmes d’accréditation et de planning de l’encadrement, mais aussi des informations plus critiques comme les bios et les données médicales des athlètes, les informations communiquées aux journalistes ou encore les temps de chronométrage aux épreuves. Il va sans dire que cet environnement informatique fortement en vue pendant la dizaine de jours des épreuves subit un grand nombre d’attaques quotidiennes.

En termes d’infrastructure, le projet intégrait plus de 10 000 postes de travail, 1800 Systèmes d’affichage de résultats, 500 ordinateurs portables, 400 serveurs Unix et 450 serveurs Windows.

Schématiquement les solutions de remontées d’alarmes se composent de trois couches :

- Le service de collecte responsable de la récupération des évènements

- Le moteur de corrélation responsable de la détection des alarmes critiques

- Les services de restitution responsable de l’affichage sur la console de contrôle

Depuis les années 2006 les techniques de corrélation d’évènements ont atteint un degré de maturité élevé qui fait qu’elles sont utilisées dans les solutions de SIEM (Security Information and Event Management) mais aussi de BAM (Business Activity Monitoring) afin de valider le bon fonctionnement des processus métiers critiques.

Cette discipline est connue sous le nom de CEP pour « Complex Events Processing » et traite différentes phases de la gestion complexe des évènements, à savoir :

- La collecte depuis les nombreux équipements hétérogènes

- L’agrégation des évènements similaires

- La normalisation afin de formater chaque évènement

- La corrélation des évènements ayant la même source

- La présentation des alarmes issues d’évènements critiques sur la console

- L’archivage des évènements à titre de preuves ou pour re-jeu

Les projets de mise en place de solutions de SIEM son généralement complexes du fait de la multitude d’actifs à intégrer et des quantités d’évènements à traiter et à stocker. L’architecture de la solution doit être bâtie en fonction de ces facteurs.

Toute l’intelligence du système réside dans l’établissement des règles de filtrage, d’agrégation et de corrélation. Celles-ci doivent faire l’objet d’un plan d’amélioration continu car il convient d’adopter une démarche pragmatique et itérative afin d’assurer le succès de la mise en place d’une solution de SIEM.