Les études se suivent et n’arrivent pas toujours aux mêmes conclusions. Il y a quelques jours, nous avons publié les résultats d’une enquête de BSI menée auprès de 10 000 personnes dans neuf pays.

Elle constatait que l’Europe et la France notamment étaient à la traine dans l’adoption de l’IA par rapport à la Chine et l’Inde. Mais, une récente étude d’ExtraHop, spécialisé dans la détection et la réponse réseau (NDR), constate que la France est à l'avant-garde en matière d'IA et d’utilisation de ChatGPT.

Le taux d’adoption y est le plus élevé (85 % utilisent fréquemment l'IA ou parfois). tout comme la confiance dans la sécurité (98 %). Baptisée « The Generative AI Tipping Point », ce rapport d’ExtraHop souligne également que les organisations françaises ont pris le plus de mesures pour régir les outils d’IA en interne.

Informations inexactes ou absurdes

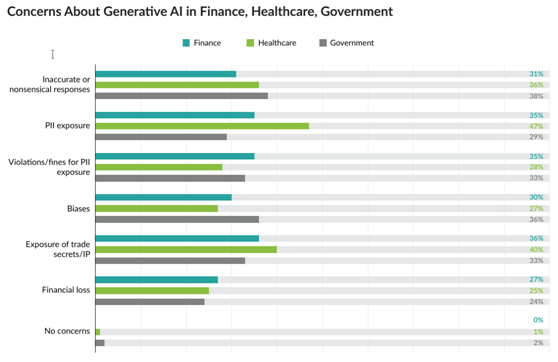

Plus de la moitié (58 %) a investi dans une technologie de surveillance, 60 % ont actuellement une politique dictant comment les employés peuvent utiliser l'IA, la même proportion propose des formations sur l'utilisation correcte de l'IA. Mais, une proportion non négligeable (45 %) a préféré interdire l'IA.Mais, le plus intéressant dans cette étude (reposant sur les réponses de 1200 professionnels de l’IT) est que la principale préoccupation des personnes interrogées est d’obtenir des informations inexactes ou absurdes, suivie de près par l’exposition de données identifiables d’un employé ou d’un client. Moins d’un quart des personnes interrogées s'inquiètent des pertes financières.

Comme d’autres études mondiales, celle-ci constate des différences majeures entre les pays ou les régions. Ainsi, Singapour et l'Australie sont les seuls pays où l'exactitude ou la cohérence des réponses n'est pas la principale préoccupation. C’est plutôt l'exposition des données identifiables des salariés ou des clients.

Concernant les Français, cette préoccupation arrive en troisième position, derrière la perte financière et la réponse "aucune préoccupation". D’un point de vue sectoriel, ceux de la finance et de la santé sont également à contre-courant de la tendance. Le premier est le plus préoccupé par l'exposition des secrets commerciaux ou de la propriété intellectuelle, de l’exposition des identifiants des collaborateurs ou des clients, et les violations de la conformité.

Plus de réglementations

Pour les responsables du secteur de la santé, l’exposition des identifiants arrive en tête (47 %), suivie par l’exposition des secrets commerciaux ou de la propriété intellectuelle (40 %).Quelle que soit la région, la tranche d'âge, le secteur d'activité, la taille de l'entreprise et le niveau d'ancienneté, la réponse est la même lorsqu’on leur demande si leur organisation prévoit d'investir dans des mesures de sécurité de l'IA générative en 2023 ? La réponse est oui, sans équivoque.

Il n'y a que deux exceptions notables : le Royaume-Uni et le secteur gouvernemental. Seule la moitié des sondés du secteur public et des entreprises du Royaume-Uni annonce des investissements. « Les chiffres du Royaume-Uni semblent déconcertants, mais c'est aussi dans ce pays que l'adoption est la plus faible. Seuls 52 % des personnes interrogées déclarent que leurs employés utilisent parfois ou souvent utilisent des outils d'IA », lit-on dans ce rapport.

Une étude récente de Deloitte a également révélé que seulement 52 % des personnes au Royaume-Uni avaient entendu parler de l’IA générative et beaucoup moins (8 %) déclaraient l’utiliser au travail.

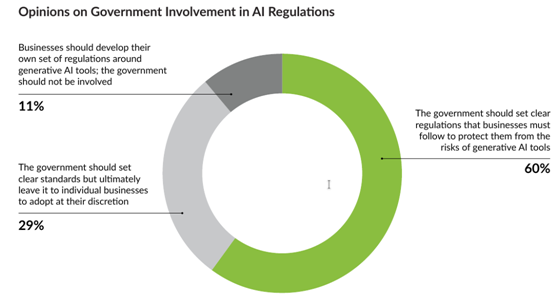

Enfin, dans le monde entier, 60 % des personnes interrogées déclarent que leur gouvernement devrait établir des règles claires et obligatoires pour les entreprises. Les Français sont les plus favorables (80 %) à une réglementation.