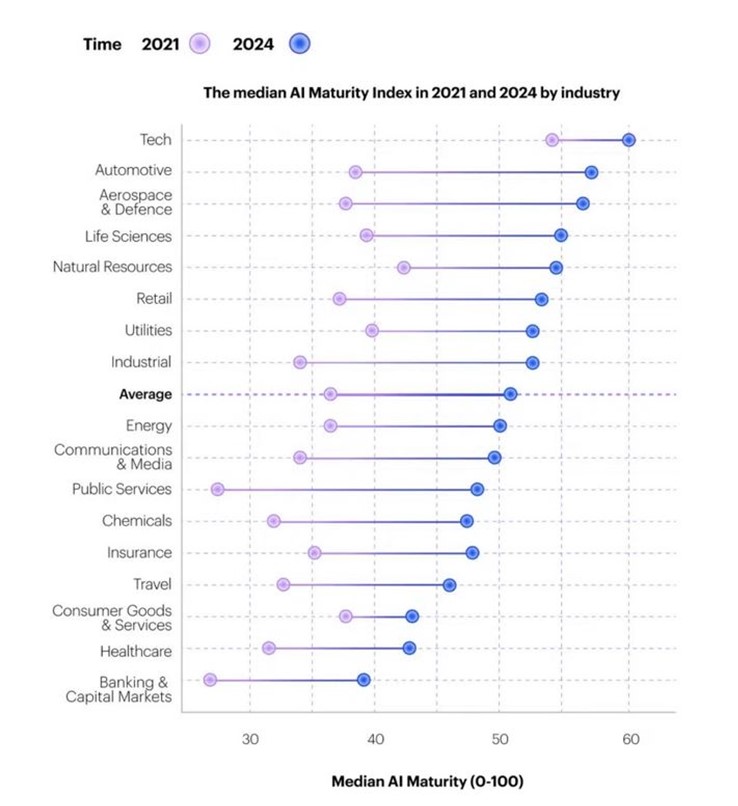

En juin 2022, le cabinet américain Accenture avait publié une étude dans laquelle il montrait que la plupart des entreprises (soit 63 %) exploitent de manière très peu efficace le potentiel de l'IA avec un score de maturité en matière d'IA de 29 sur 100.

Le graphique ci-dessous du même cabinet montre l’écart actuel parmi les secteurs économiques et publics sur leur maturité vis-à-vis de l’utilisation de l’IA entre 2022 et les projections sur 2024. A noter, l’évolution significative de la maturité (autour de 20 points d’indice sur 100) des domaines aéronautique & espace, les services publics, l’industrie et l’automobile.

La gouvernance des données est insuffisante et l’impact de l’IA n’est pas suffisamment évalué

Alors que l’appétence pour l’IA et l’IA générative reste très forte et en augmentation, la plupart des organisations ne sont pas prêtes pour l’intégrer à grande échelle à leur processus de travail. C’est l’opinion de la directrice générale d'Accenture, Julie Sweet. Selon la dirigeante, les entreprises et institutions publiques ne disposent pas à ce jour d'une gestion assez robuste et mature de leurs données pour tirer parti du potentiel de l’IA. En cause, notamment, la protection des données sensibles des clients et fournisseurs.« Nous en sommes encore au stade où la plupart des dirigeants d’entreprise, lorsqu'on leur demande s'il y a quelqu'un dans leur organisation qui peut leur dire où l'IA est utilisée, quels sont les risques et comment ils sont pris en compte, répondent toujours "non". » affirme Julie Sweet.

Deloitte, un des quatre cabinets d’audit et conseil au monde, identifie 3 facteurs principaux de risques de l’IA. Le premier item porte sur la qualité, la quantité et la pertinence des données utilisées. Les biais et erreurs dans les jeux de données utilisés par les algorithmes seront répercutés ou pire, amplifiés.

Le deuxième point concerne l’opacité des processus. Les collaborateurs s’appuieront à terme sur des méthodes statistiques très complexes, basées sur des milliers de paramètres. Comment, dans ces conditions, explique Deloitte, interpréter les décisions prises par (ou avec) les outils d’IA et les rendre intelligibles aux humains ? Les questions d’éthique se posent aussi avec acuité.

Enfin, des dysfonctionnements sont prévoir. Les algorithmes ne disposent pas des capacités de compréhension conceptuelle et de sens commun propres à l’homme, face à des évènements inédits puisqu’ils ne sont pas intégrés en toute logique aux organigrammes de traitement. Ces derniers ne pouvant effectuer que des prédictions. Une situation peu adaptée aux processus temps réel comme ceux mise en ouvre dans les véhicules autonomes et autres usages.