Cette évolution témoigne d’une stratégie de plateforme intégrée, où les briques historiques (Kafka, Flink) s’enrichissent de capacités natives du cloud, taillées pour les usages analytiques et opérationnels. En permettant la combinaison des données en temps réel et historiques, tout en renforçant la protection des pipelines Flink, la plateforme de Confluent fournit aux agents intelligents un socle fiable et contextualisé pour leurs actions automatisées.

Un seul langage et une seule interface

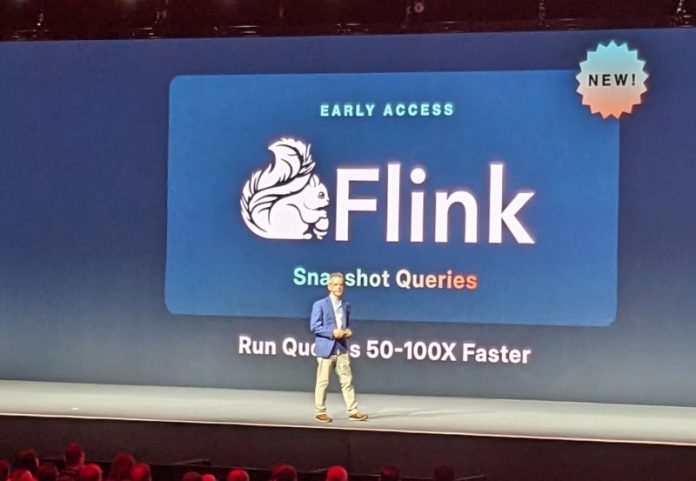

Au cœur de cette annonce figure la disponibilité des Snapshot Queries pour Apache Flink dans Confluent Cloud. Cette fonctionnalité permet aux entreprises de traiter des données en streaming et en batch avec un seul langage et une seule interface, éliminant ainsi les cloisonnements historiques entre les flux et les bases. Intégrée de manière fluide avec Tableflow, elle simplifie l’accès aux données passées, sans générer de charges de travail supplémentaires. Ce traitement unifié est particulièrement précieux dans les cas d’usage critiques, comme la détection de fraude ou la surveillance médicale, où il est impératif de croiser signaux en temps réel et contexte historique pour générer des décisions pertinentes et explicables.Pour accompagner cet ajout fonctionnel, Confluent renforce également la sécurité et la connectivité de sa plateforme. Le routage via Confluent Cloud Network (CCN) permet aux entreprises de réutiliser leurs réseaux privés existants pour connecter leurs traitements Flink, tout en garantissant une isolation complète du trafic. Cette solution, désormais accessible en disponibilité générale sur AWS, répond aux exigences de nombreuses organisations opérant dans des environnements hybrides et multicloud. En parallèle, le filtrage IP vient ajouter un niveau de contrôle granulaire sur les accès aux pipelines Flink publics. Il permet de limiter le trafic aux seules adresses IP autorisées et de mieux tracer les tentatives d’accès non conformes.

Au cœur de l’automatisation intelligente des processus

Cette annonce s’inscrit dans une stratégie de fond engagée par Confluent depuis plusieurs trimestres, visant à transformer son cloud en une plateforme de référence pour le traitement des données distribuées au service de l’IA. Après avoir lancé Tableflow pour fluidifier l’ingestion tabulaire, introduit le Cluster Linking multicloud, et annoncé un connecteur source pour Snowflake, l’éditeur confirme son ambition de proposer une infrastructure unifiée et évolutive, capable de soutenir les flux décisionnels de bout en bout. En combinant ingestion, traitement, sécurité et intégration native avec les principaux écosystèmes analytiques, Confluent se positionne au cœur de l’automatisation intelligente des processus métiers.La montée en puissance des agents IA, capables non seulement de générer des réponses, mais aussi d’agir de manière autonome, impose en effet de nouvelles exigences en matière de qualité, de fraîcheur et de contextualisation des données. Comme le souligne Stewart Bond, vice-président en charge de la data intelligence chez IDC, l’unification des données structurées, non structurées, temps réel et historiques dans un environnement cohérent est devenue un prérequis pour exploiter pleinement le potentiel de l’IA agentique. Cette tendance, qui touche désormais des secteurs aussi divers que la finance, la santé ou l’industrie, place les plateformes de data streaming au cœur des priorités des directions techniques et métiers.

Un socle technologique pour l’automatisation intelligente

Avec cette nouvelle évolution de son offre cloud, Confluent ne se contente pas de suivre le mouvement du marché. L’éditeur affine une stratégie centrée sur la mise à disposition d’un socle technologique pour l’automatisation intelligente, en s’appuyant sur des fondations open source largement adoptées, des services gérés à forte valeur ajoutée, et une gouvernance rigoureuse des flux de données. Dans un marché marqué par la fragmentation des outils et la prolifération des interfaces intelligentes, la promesse d’unifier le traitement temps réel et batch, tout en garantissant la sécurité et la compatibilité multienvironnements, devient un différenciateur stratégique.Ce positionnement renforce la logique d’infrastructure en « système nerveux » que nous avions déjà analysée dans ses précédentes annonces publiées sur IT Social, notamment autour de Tableflow et de l’intégration native de Flink. En étoffant progressivement les couches fonctionnelles et sécuritaires de sa plateforme, l’éditeur trace les contours d’une offre cloud cohérente et résolument tournée vers la convergence des flux et des agents.