L’analytique est comme un ruisseau dont l’eau doit être pure, provenir de différentes sources et suivre un cours déterminé. Pour l’exploiter, il faut un réseau de conduites, des sources, des pompes, des aqueducs, des filtres, des conteneurs, des valves, des citernes et d’autres artefacts nécessaires pour identifier, transformer, traiter, analyser, et fournir la ressource.

Avec l’entrée dans l’ère du Big data, l’analytique, ou l’analyse des données, s’est imposé comme l’application la plus appropriée pour faire parler les données accumulées dans les dépôts numériques des organisations. Cependant, la mise en place de l’analytique est une démarche structurante en elle-même. Les données sont une ressource qui doit également être identifiée, recueillie, transformée et analysée pour en tirer des enseignements. Selon IDC, « le but ultime d’un pipeline “Data to Insights” est d’influencer une meilleure prise de décision (bénéfice de premier ordre) et de fournir une valeur commerciale (bénéfice de second ordre) à la fois par les humains et les machines ».

Comme l’exploitation de « l’or bleu », l’analytique nécessite l’alignement d’une chaîne de traitement complexe destinée à analyser des données qui ont des caractéristiques variées et qui proviennent d’une multitude de sources, y compris les médias sociaux, les points terminaux (ordinateurs, serveurs, IoT…), les fichiers, la vidéo, le texte, l’image, la RFID et même les données GPS.

Un changement de paradigme s’impose

L’avènement de ces infrastructures orientées données a complètement bouleversé les systèmes traditionnels de traitement comme les bases de données relationnelles. Elles ont engendré une multitude de nouvelles technologies, d’approches et de plateformes. Les clés du succès de la mise en place et de l’exploitation opérationnelle d’une telle chaîne de traitement reposent sur un changement de paradigme sur la manière dont les données ont été utilisées jusqu’à présent dans les entreprises.

C’est pour cette raison qu’il faut la vélocité d’un athlète, l’endurance d’un coureur de fond et l’habileté d’un artisan pour mettre en place les briques nécessaires à l’analytique. Nous y ajouterons la patience d’un bédouin, nécessaire pour essuyer les plâtres et mettre en place des modèles fiables et respectueux des réglementations sur la vie privée et l’utilisation des données personnelles.

C’est en résumé ce qui ressort d’une étude, Data is the New Water : The Importance of Investing in Data and Analytics Pipelines, publiée par Qlik et menée par IDC en avril 2020. « Les données représentent pour les entreprises françaises une ressource essentielle dans la course à la compétitivité et c’est d’autant plus vrai dans un contexte de crise. Pourtant, les différentes étapes de la chaîne analytique restent encore un défi, et ce dès le début du cycle », explique le rapport.

Difficulté à identifier les sources de données pertinentes

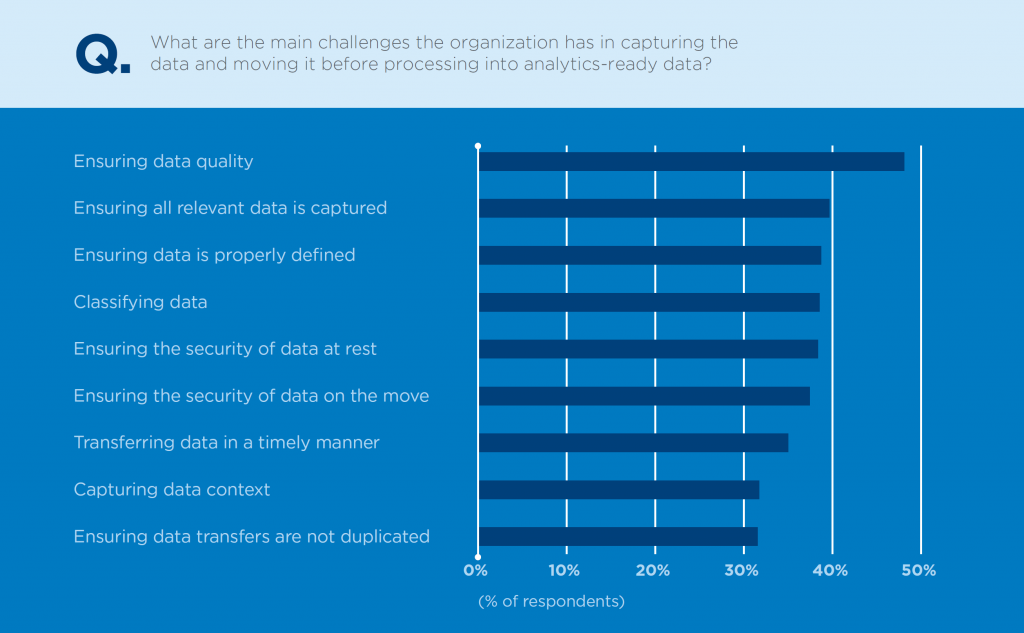

Réalisée auprès de 1 200 entreprises de plus de 1 000 salariés, dont 100 entreprises françaises, l’étude montre qu’une majorité de répondants bute encore sur la qualité des données et leur pertinence. De tous les répondants français, 66 % considèrent que l’identification des données pertinentes reste un défi, et 76 % jugent largement perfectible leur collecte de données à des fins d’analyse. La raison de cette incertitude réside dans la difficulté à identifier les sources de données pertinentes, souvent en raison de l’absence d’un catalogue de données.

Par ailleurs, une grande partie des données dont dispose une entreprise reste inutilisée ou sous-utilisée. Selon les répondants français, 41 % des données collectées ont peu ou pas du tout été analysées. Ils sont 72 % à juger que la transformation des données en vue d’être analysées est largement perfectible.

Heureusement que les technologies de traitement de la donnée évoluent rapidement, rassure le rapport. « Les dernières technologies d’identification, de collecte, de transformation et d’analyse des données offrent un nouvel ensemble de fonctions d’automatisation pour améliorer la productivité et la résilience des solutions ». Reste d’autres écueils soulignés dans le rapport, comme l’évolution laborieuse des processus décisionnels, la difficulté à trouver les compétences spécialisées soit dans l’analyse des données ou des spécialistes des problématiques métier. Et même si les équipes sont formées, reste la difficulté de faire collaborer ces compétences pour créer des pipelines agiles.