Alors que le marché de l’IA générative se développe à une allure surprenante, la stratégie de Nvidia visant à fournir des fonctions de sécurité qui aideront les entreprises à aligner leurs services intelligents sur les exigences de sécurité, de confidentialité et de sûreté afin que ces moteurs d’innovation restent sur la bonne voie.

Du code, des exemples et de la documentation

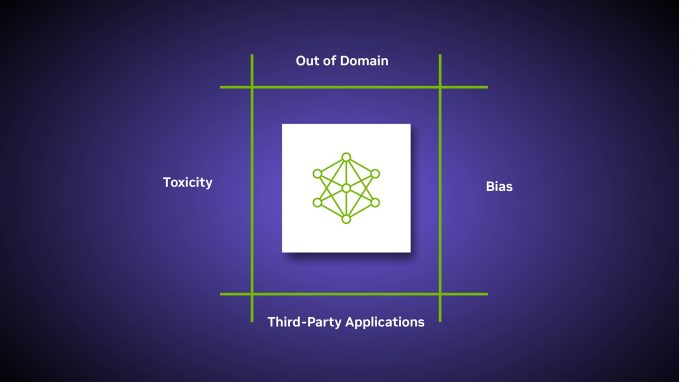

NeMo Guardrails fournit du code, des exemples et de la documentation pour permettre aux entreprises de s’assurer que les applications intelligentes alimentées par des LLM sont précises, appropriées, pertinentes et sécurisées. La sécurité dans l’IA générative est une préoccupation de l’ensemble de l’industrie et Nvidia a conçu NeMo Guardrails pour fonctionner avec tous les LLM, tels que ChatGPT d’OpenAI. Le logiciel permet aux développeurs de mettre en place trois types de limites. Les garde-fous thématiques préviennent les applications de dévier vers des domaines qui ne sont pas concernés par les sujets abordés. Par exemple, ils empêchent les assistants du service clientèle de répondre à des questions sur la météo.Les garde-fous de sécurité sont de deux sortes. Ceux qui garantissent que les IA répondent avec des informations exactes et appropriées. Ils peuvent filtrer le langage indésirable et veiller à ce que les références ne soient faites qu’à des sources crédibles ; et les garde-fous de sécurité qui limitent la capacité des applications à l’établissement de connexions qu’avec des applications tierces réputées sûres.

NeMo Guardrails s’appuie sur Colang, un langage de modélisation et un moteur d’exécution développés par Nvidia pour l’IA conversationnelle. L’objectif de Colang est de permettre aux développeurs de créer des applications d’IA conversationnelle capables d’interagir avec les humains de manière naturelle. Il est également conçu pour fonctionner avec tous les outils utilisés par les développeurs d’applications d’entreprise.

Disponible en code open source sur GitHub

Dans un marché où la tendance est à l’usage de plus en plus répandu de l’IA générative et des LLM, adoptés par de nombreuses industries pour créer des chatbots, résumer de longs documents, écrire des logiciels et accélérer la conception et le design, la stratégie de Nvidia avec NeMo Guardrails répond aux craintes sécuritaires et pour leur réputation des entreprises désireuses de développer des LLM pour leurs besoins. À mesure que ces applications se généralisent, il est essentiel de garantir leur sûreté, leur sécurité et leur fiabilité. L’approche de Nvidia face à ce défi s’appuie sur le modèle open source pour proposer une fonction spécifique dans la chaîne de traitement de l’IA et favoriser son expansion.Nvidia intègre NeMo Guardrails dans le framework Nvidia NeMo disponible en code open source sur GitHub. Les entreprises peuvent également l’obtenir en tant que package complet et pris en charge dans le cadre de la plateforme logicielle Nvidia AI Enterprise, et via le service NeMo inclus dans les services cloud Nvidia AI Foundations.

NeMo Guardrails fait partie de l’environnement de développement Nvidia NeMo, qui comprend tout ce dont les utilisateurs ont besoin pour former et ajuster les modèles de langage en utilisant les données propriétaires d’une entreprise. Le cadre NeMo est déjà disponible en tant que code source ouvert sur GitHub. Les entreprises peuvent également l’obtenir en tant que package complet et pris en charge, dans le cadre de la plateforme logicielle Nvidia AI Enterprise.