En effet, l’IA générative devient un élément essentiel de l’informatique moderne, avec des assistants AI, des copilotes et d’autres fonctionnalités similaires gagnant rapidement de nouveaux utilisateurs. Mais, alors que les cas d’usage de l’intelligence artificielle se répandent dans divers secteurs, la nécessité de disposer d’outils de surveillance et d’observabilité efficaces, spécialement conçus pour les systèmes d’IA, s’accroît d’autant plus. Pour compliquer les choses, le paysage technologique de l’IA générative évolue rapidement, avec de nouveaux cadres d’application, bases de données vectorielles et chaînes de service qui émergent régulièrement. Ce dynamisme souligne le besoin d’outils d’observabilité aussi adaptables que la technologie qu’ils supervisent.

Surveiller les paramètres spécifiques à l’IA

Les fournisseurs de services et d’application et les éditeurs d’outils de surveillance et d’observabilité font évoluer leurs offres pour répondre aux défis et aux demandes spécifiques du marché de l’IA. En effet, les modèles d’IA s’accompagnent de paramètres uniques par rapport aux applications logicielles conventionnelles, notamment des facteurs tels que l’exactitude du modèle, la précision, le rappel, le score F1 et le temps d’inférence. Au fil du temps, les modèles d’IA peuvent présenter ce que l’on appelle une dérive de modèle, c’est-à-dire que les données sur lesquelles ils ont été formés ne sont plus représentatives. Pour remédier à ce problème, les outils d’observabilité dédiés intègrent des fonctions qui alertent les data scientistes et les ingénieurs des données sur tout écart par rapport aux performances attendues du modèle.Pour répondre à ces préoccupations, Datadog propose désormais une vaste gamme d’outils d’observabilité conçus pour les applications basées sur LLM. Ces outils ont été développés pour remonter les informations concernant la santé, le coût et la précision des applications, quel que soit l’environnement. La suite de Datadog s’intègre ainsi à des plateformes et des services tels que Nvidia, CoreWeave, AWS, Azure, Google Cloud, Weaviate, Pinecone, Airbyte, Torchserve, VertexAI, Amazon Sagemaker, OpenAI, Azure OpenAI et LangChain.

Une version bêta dédiée à l’observabilité LLM

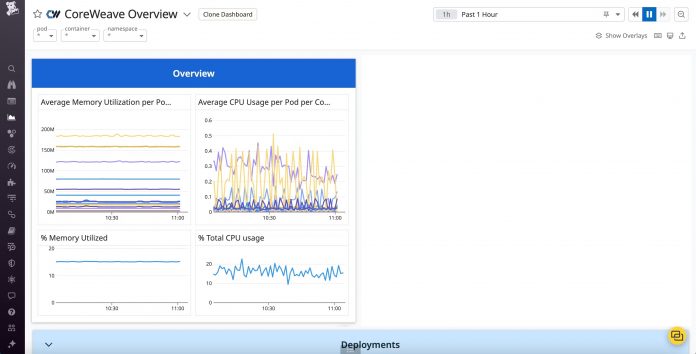

Datadog a également lancé une version bêta dédiée à l’observabilité LLM. Cette plateforme fusionne des données issues de sources variées, notamment des applications, des modèles et des intégrations. Sa principale fonction est d’identifier et de corriger les problèmes d’application du monde réel. Pour ajouter de la profondeur à ces fonctionnalités, des fonctions avancées d’observabilité LLM ont été incorporées, offrant des outils tels que des catalogues de modèles, des moniteurs de performance et des mécanismes de détection de dérive.Pour mieux prendre en compte la demande en puissance computationnelle et la gestion des gros volumes, Datadog a collaboré avec Nvidia DCGM Exporter et CoreWeave. Sur le front de la gestion des données, les tableaux de bord OOTB de Datadog pour Weaviate et Pinecone proposent une vue approfondie de la santé des bases de données vectorielles. De plus, l’intégration de la plateforme avec Airbyte permet de bénéficier d’une connectivité élargie vers des sources de données diverses.

En ce qui concerne le déploiement de modèles, l’intégration avec Vertex AI et Amazon SageMaker proposent des métriques détaillées pour les nœuds de formation et d’inférence. De plus, son association avec OpenAI surveille l’utilisation et la consommation des données, tandis que la collaboration prochainement lancée avec Amazon Bedrock promettra de proposer une fenêtre sur les performances des API. Enfin, avec le tableau de bord Datadog LangChain, les utilisateurs obtiennent une vue panoramique de la performance des applications, tandis que le tableau de bord Amazon CodeWhisperer donne une vue sur les métriques d’engagement des utilisateurs.