L’objectif est de proposer un écosystème complet, intégré et optimisé pour les plateformes de Nvidia, notamment les GPU Nvidia H100. NVIDIA TensorRT-LLM est un élément clé de la stratégie de Nvidia visant à faire progresser l’IA générative et à permettre aux développeurs de créer des applications révolutionnaires avec les LLM.

En effet, ces entreprises ont utilisé TensorRT-LLM pour améliorer leurs performances d’inférence LLM et l’expérience utilisateur. Par exemple, TensorRT-LLM peut accélérer le résumé de texte de huit fois en utilisant GPT-J-6B sur les GPU H100 par rapport aux GPU A100. Il peut également accélérer l’inférence Llama 2 de 4,6 fois par rapport aux GPU A100. La solution a pour but de permettre aux développeurs d’être plus productifs, en offrant des performances très rapides et une personnalisation rapide sans connaissances approfondies en C++ ou CUDA.

TensorRT-LLM intègre le compilateur d’apprentissage profond de TensorRT, les noyaux optimisés de FasterTransformer, le pré et le post-traitement, et les primitives de communication multi-GPU/multinœuds dans une API Python opensource, ceci pour définir, optimiser et exécuter des LLMpour l’inférence en production. TensorRT-LLM prend en charge de nouvelles architectures et des améliorations au fur et à mesure de l’évolution des LLM, et peut-être facilement personnalisé. TensorRT-LLM sera disponible dans les prochaines semaines et peut être téléchargé en accès anticipé pour les développeurs Nvidia enregistrés.

Un écosystème complet, matériel et logiciel

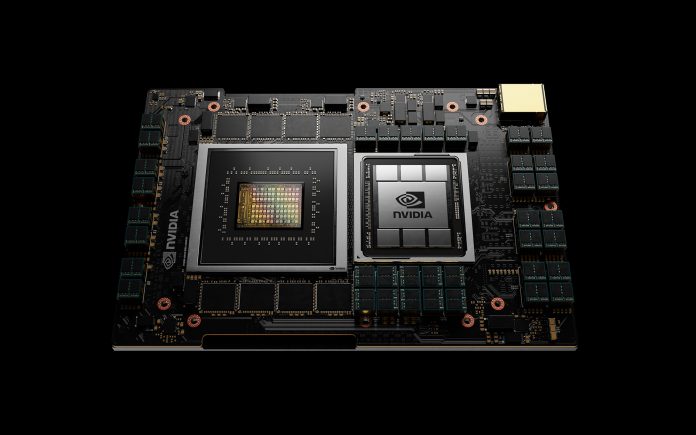

Avec cette annonce, le leader dans le domaine des processeurs graphiques, qui sont essentiels pour les applications de calcul haute performance, des jeux et de l’intelligence artificielle, se renforce sur le marché des LLM et de l’inférence. Nvidia a adopté une stratégie de développement qui consiste à fournir des solutions matérielles et logicielles qui permettent aux développeurs, aux chercheurs et aux entreprises d’exploiter la puissance de l’IA générative pour diverses applications et divers domaines.Sur le plan matériel, Nvidia propose des GPU (processeurs graphiques) optimisés pour l’exécution d’algorithmes d’apprentissage profond et de modèles massifs d’IA générative. Nvidia fournit également des systèmes DGX, qui sont des plateformes intégrées combinant plusieurs GPU, CPU, stockage, réseau et logiciel pour fournir des solutions d’IA prêtes à l’emploi.

Du côté des logiciels, Nvidia développe et prend en charge divers environnements et outils qui facilitent le développement et le déploiement de modèles d’IA générative. Par exemple, Cuda est une plateforme de programmation qui permet aux développeurs d’accéder aux capacités du GPU pour des opérations informatiques générales. TensorRT est une bibliothèque d’exécution qui optimise et exécute les modèles d’IA générative sur les GPU pour l’inférence. Rapids est une suite de bibliothèques opensource qui permettent des flux de travail de science des données sur les GPU. Nvidia collabore également avec d’autres organisations d’IA, comme OpenAI, pour donner accès à des modèles et techniques d’IA générative de pointe, comme ChatGPT et DALL-E 2.

Il s’agit de proposer aux entreprises des environnements leur permettant de mettre à l’échelle les charges de travail d’intelligence artificielle et d’apprentissage automatique dans différents environnements, tel que sur site, cloud ou cloud hybride.