Ian Buck, vice-président de la division Accelerated Computing de Nvidia, a souligné le pouvoir de transformation de l'IA générative dans tous les secteurs. « L'IA générative transforme rapidement les entreprises, ouvre de nouvelles perspectives et accélère les découvertes dans les secteurs de la santé, de la finance, des services aux entreprises et dans bien d'autres secteurs », affirme-t-il. « Avec la production à grande échelle des superpuces Grace Hopper en cours, les fabricants mondiaux seront bientôt en mesure de proposer l'infrastructure accélérée nécessaire pour construire et déployer des applications d'IA générative qui exploitent des données propriétaires ».

Une demande croissante de solutions informatiques plus puissantes

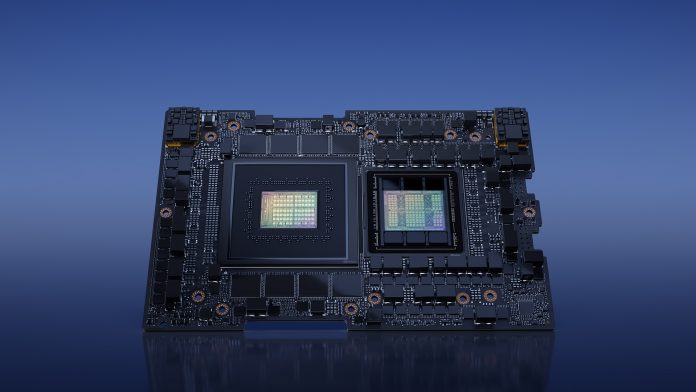

Si l’accent est mis sur les capacités de transfert, la véritable nouvelle est l’émergence de puces spécialisée sur un marché qui intègre massivement les capacités d’IA et de calcul intensif pour l’exploitation des données et l’analytique et la création de modèles. Dans ce contexte, un matériel spécialisé, des architectures hybrides, permettant des calculs intensifs, ainsi que la personnalisation et l'efficacité énergétique visent à répondre à une demande croissante de solutions informatiques plus puissantes, plus efficaces et plus spécialisées pour soutenir les applications toujours plus nombreuses de l'IA et du HPC.Les principaux hyperscalers et centres de supercalcul en Europe et aux États-Unis sont clients naturels, mais aussi les entreprises qui veulent déployer et gérer leurs propres systèmes d’inférence et de HPC. Nvidia a établi des partenariats clés avec des fabricants taïwanais, dont AAEON, Advantech, ASRock Rack, ASUS et bien d'autres, qui devraient mettre sur le marché une gamme variée de systèmes alimentés par le GH200. Les fabricants mondiaux de serveurs tels que Cisco, Dell Technologies, Hewlett Packard Enterprise, Lenovo, Supermicro et Eviden sont également sur les rangs pour proposer des systèmes accélérés par Nvidia.

Pour assurer un atterrissage sans à-coups dans les centres de données et les infrastructures propriétaires, Nvidia a collaboré avec des partenaires cloud mondiaux. AWS, Google Cloud, Microsoft Azure et d'autres sont parmi les fournisseurs de cloud qui offrent un support pour les GPU Nvidia H100 et Nvidia L4.

Un écosystème d’outils qui se complètent

En développant des puces est des environnements de développement fonctionnant de concert, Nvidia met en place un véritable écosystème pour le développement d’applications cognitives. Il est composé, entre autres, des architectures pour GPU et CPU, Grace, Hopper et Ada Lovelace de Nvidia, qui permettent de déployer des plateformes complètes. Nvidia AI par exemple propose plus de 100 environnements de développement, avec des modèles pré-entraînés et des outils pour simplifier le développement et le déploiement de l'IA de production, y compris l'IA générative, la vision par ordinateur et l'IA vocale.La plateforme de développement Nvidia Omniverse permet en outre une collaboration en temps réel dans des environnements partagés, en tirant parti de la puissance du cadre Universal Scene Description. En outre, la plateforme Nvidia RTX accélère le processus des créateurs de contenu et des développeurs, en permettant un rendu photoréaliste en temps réel et un traitement des graphiques, des vidéos et des images optimisé par l'IA.

Les systèmes équipés de Grace Hopper GH200 devraient être disponibles dans le courant de l'année.