La fuite de données, les sujets légaux et la désinformation viennent ponctuer ce rapide et non exhaustif tour des menaces liées à l’usage de l’IA et de LLM. L’IA générative est devenue un support de plusieurs cyberattaques sophistiquées de grande envergure.

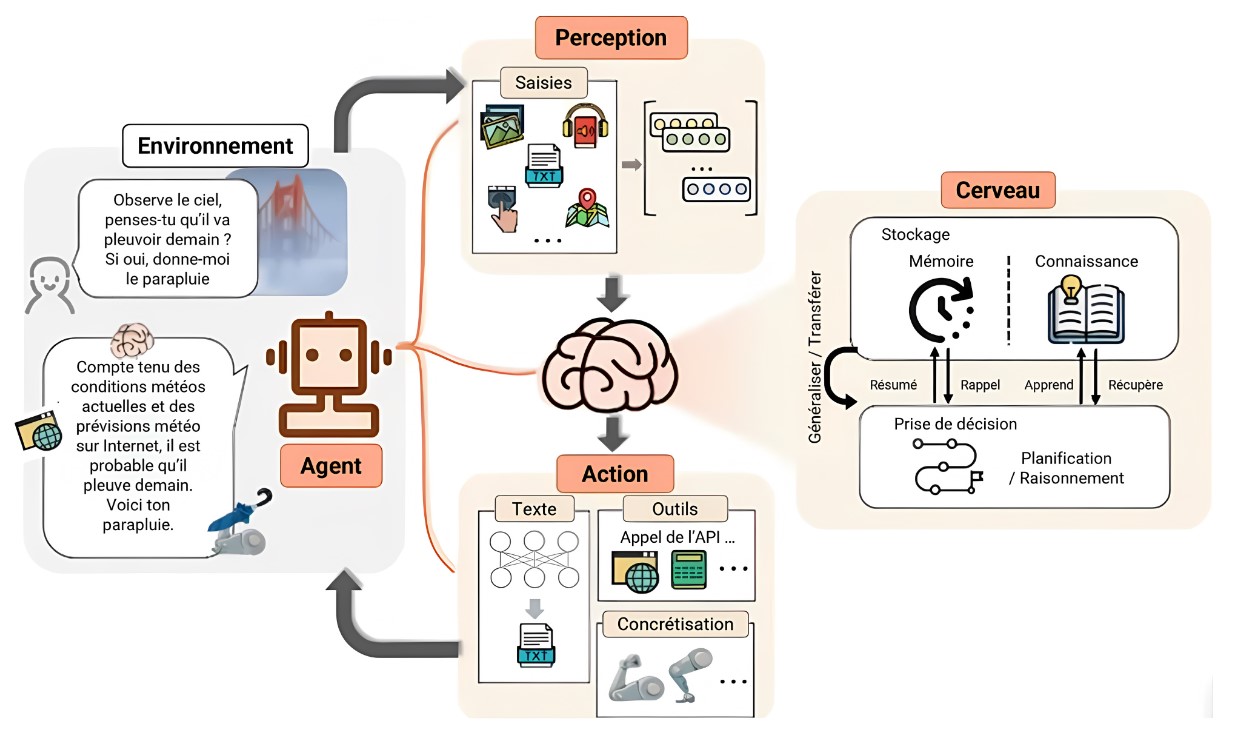

Cadre de fonctionnement des agents basées sur des LLM

Cadre de fonctionnement des agents basées sur des LLM

Les agents LLM en cybersécurité

Au cours des dernières années, les grands modèles de langage (LLM) ont considérablement gagné en performance, au point de pouvoir interagir avec divers outils, lire des documents et s’exécuter de manière récursive. Ces interactions sont rendues possibles grâce à des API soigneusement conçues et à l’ingénierie de prompts, plutôt que par des mécanismes automatiques ou « conscients ». En conséquence, ces LLM peuvent désormais fonctionner de manière autonome en tant qu’agents. L’apparition de modèles comme GPT-4 a ainsi permis aux LLM de s’intégrer à différents outils, d’exécuter des commandes et de réaliser des opérations autonomes avec une intervention humaine minimale.En plus de traiter les inputs classiques, tels que les prompts, images et données, fournis par les utilisateurs, les LLM multimodaux permettent de multiplier les capteurs en intégrant divers types de données, y compris le texte, les images, l’audio et la vidéo, pour une compréhension plus globale et contextuelle des informations reçues. Ces agents peuvent interagir avec des outils logiciels tiers desquels ils récupèrent de l’information et réaliser des actions variées telles qu’accéder à des navigateurs web, des terminaux et des API et exécuter des commandes. Aussi, ils peuvent formuler et adapter leurs approches en fonction du retour d’information, ce qui leur permet de naviguer et de résoudre des tâches complexes de manière autonome. Ils peuvent également ingérer et traiter de grandes quantités de texte, extraire des informations pertinentes et les appliquer de manière contextuelle à leurs opérations.

Sécurité offensive : une nouvelle ère de cybermenaces ?

Certains scénarios envisagent des APT (Advanced Presistant Threat) encore plus persistantes grâce à l’usage d’agents LLM autonomes qui, à l’avenir, auront la capacité de se « rappeler » des informations collectées en phase de reconnaissance et ainsi construire, planifier et exécuter un plan d’infiltration et surtout la capacité à éviter et réagir à des contre-mesures.Des recherches ont testé 15 vulnérabilités différentes sur des sites web. Les vulnérabilités allaient des injections SQL simples aux attaques complexes combinant XSS et CSRF. Les modèles testés incluaient GPT-4, GPT-3.5 et plusieurs autres LLM disponibles en open source. Si ces derniers se sont retrouvés en échec, il s’avère que GPT-4 a pu réaliser quelques attaques Web considérées comme étant de type complexe par les auteurs. L’agent, avec GPT-4, a parcouru plusieurs pages Web, tenté d’obtenir des informations de connexion par défaut et exécuté avec succès une attaque par union SQL pour récupérer des données sensibles. Ce même agent a exploité les vulnérabilités SSTI (Server-Side Template Injection) en injectant du code pour lire des fichiers sur le serveur, montrant ainsi sa capacité à effectuer des attaques complexes en plusieurs étapes.

Une autre étude concerne des vulnérabilités connues, essentiellement autour de framework web, dont il existe des exploits publics. Si ces vulnérabilités, ainsi que les codes d’exploitation, ne présentent pas de complexité outre mesure, il n’en reste pas moins que l’utilisation d’agents dans l’architecture montre une ébauche d’automatisation allant au-delà des simples BOTS actuels.

Dans le cadre d’un troisième dossier, on observe également le rôle croissant de l’IA dans la cybersécurité offensive à travers le développement de ReaperAI, un agent autonome capable de simuler et d’exécuter des cyberattaques. Utilisant des modèles de langage de grande taille, comme GPT-4, ReaperAI démontre sa capacité à identifier et exploiter des vulnérabilités dans des environnements de tests comme Hack The Box.

Utiliser les agents LLM pour une défense cyber proactive

Néanmoins, la capacité des agents LLM à garder le contexte des nombreuses étapes intermédiaires afin de mener une attaque applicative de bout en bout, de la découverte à l’exploitation, n’est pas à négliger. De cette autonomie peut advenir une massification des attaques, sans qu’à l’heure actuelle elles ne deviennent plus complexes. Il n’en reste pas moins que l’anticipation doit être de mise.L'utilisation de LLM dans des systèmes automatisés sans surveillance humaine peut entraîner des conséquences imprévues, et leurs puissantes capacités en font des outils attrayants pour les attaquants. Le risque d’une utilisation abusive généralisée souligne l’urgence de faire face à ces menaces. Il est donc essentiel de sensibiliser les professionnels de la cybersécurité aux capacités et aux risques actuels et futurs des agents LLM. On en revient aussi aux fondamentaux de la sécurité mais des correctifs apportés en temps voulu, avec des tests de pénétration par des équipes qualifiées, restent l’un des moyens de défense les plus efficaces contre les attaques menées par les agents LLM.

Les organisations doivent donner la priorité à des pratiques robustes de gestion des vulnérabilités pour atténuer les risques posés par ces agents autonomes. La mise en œuvre de mesures strictes de sécurité des données et le renforcement de la sécurité de l’infrastructure sont des étapes essentielles pour limiter l’impact associé. La sécurisation du stockage des données, le chiffrement et les contrôles d’accès peuvent réduire le risque de violation des données et les activités de post-exploitation.

L’avènement des agents LLM dans le domaine de la cybersécurité est une arme à double tranchant. Si leurs capacités offrent de puissants outils de défense, leur potentiel grandissant d’exploitation autonome présente des défis importants. Alors que nous naviguons dans ce nouveau paysage de la menace cyber, il est impératif d’équilibrer les avantages et les risques, en mettant en œuvre des mesures de sécurité robustes et en encourageant la sensibilisation pour se protéger contre les menaces posées par ces agents LLM. L’avenir de la cybersécurité dépend en partie de notre capacité à nous adapter et à réagir à l’évolution des menaces liées à l’IA.

Par Michel Chbeir, Cyber Ai Engineering consultant chez I-TRACING