En effet, l’un des défis du déploiement d’applications d’intelligence artificielle est de s’assurer que l’infrastructure sous-jacente peut prendre en charge les exigences de calcul et de traitement des données à haute performance des charges de travail d’IA. Pour répondre à ce besoin, VMware a collaboré avec des partenaires tels que Nvidia, Hugging Face, Ray, PyTorch et Kubeflow, pour définir des architectures de référence validées avec les fabricants de serveurs partenaires : Dell, Hewlett Packard Enterprise (HPE) et Lenovo.

Des systèmes prêts à déployer

Il s’agit de proposer aux entreprises des systèmes prêts à déployer pour accélérer leurs initiatives en matière d’IA et obtenir plus rapidement des inférences et des résultats commerciaux. Jensen Huang, CEO de Nvidia, parle d’une « nouvelle ère informatique », affirmant que « toutes les industries s’empressent d’adopter les technologies d’IA générative ».VMware Private AI Foundation permet aux entreprises de personnaliser et de déployer des modèles d’IA générative, sur site ou dans le cloud. La solution permet d’utiliser une variété de solutions d’IA commerciales, des référentiels open-source ou des offres d’éditeurs de logiciels indépendants. Son intégration en amont permet de réduire les coûts et la complexité du déploiement de l’IA, tout en proposant une plateforme performante. Cela signifie que les clients peuvent profiter des performances des systèmes non virtualisés tout en bénéficiant des avantages de la virtualisation, notamment une gestion simplifiée et la sécurité de niveau professionnel.

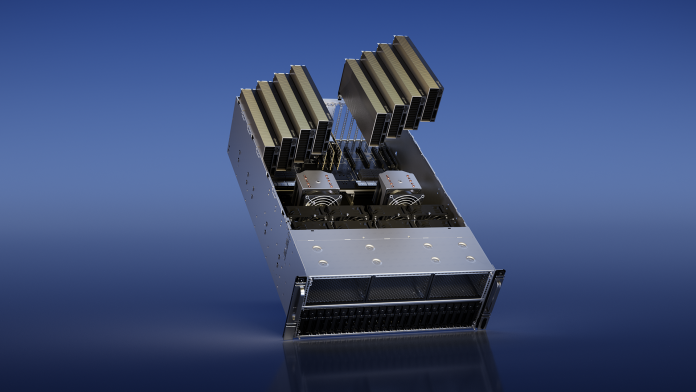

Des serveurs à base de GPU et de DPU Nvidia

Concernant les plateformes matérielles proposées, les serveurs « AI-ready » de Nvidia seront équipés des nouveaux GPU Nvidia L40S, des DPU Nvidia BlueField-3 et du logiciel Nvidia AI Enterprise. Ces serveurs sont conçus pour permettre aux entreprises de parachever les modèles de base de l’IA générative et de déployer des applications telles que les chatbots intelligents.Les serveurs L40S de Nvidia sont conçus pour des tâches d’IA complexes avec des charges massives. Ils sont dotés de TensorCores de quatrième génération et d’un FP8 Transformer Engine, ce qui apporte des avantages significatifs en termes de puissance de traitement et de vitesse par rapport à la génération précédente de GPU Tensor Core Nvidia A100.

La demande de solutions intégrées augmente

Des composants supplémentaires comme les DPU NvidiaBlueField accélèrent et optimisent la charge de calcul de la virtualisation, de la mise en réseau, du stockage et de la sécurité. Il s’agit d’une solution complète conçue pour les applications d’IA générative, mais sans s’y limiter, comme la découverte de médicaments, les descriptions de produits de vente au détail et la détection des fraudes. Les serveurs Nvidia AI-ready équipés de GPU L40S et de DPU BlueField seront disponibles d’ici à la fin de l’année, et les instances seront disponibles auprès des fournisseurs de services cloud dans les mois à venir.Le partenariat entre Nvidia et VMware, aux côtés de fabricants mondiaux de systèmes, peut être considéré comme une évolution majeure dans la constitution d’écosystèmes rassemblant des solutions matérielles et logicielles intégrées pour l’IA.À mesure que les entreprises évoluent pour devenir plus axées sur les données et l’IA, la demande de solutions intégrées augmente rapidement. Les entreprises ne veulent plus être confrontées à la complexité de l’assemblage de matériel et de logiciels provenant de plusieurs fournisseurs. Un écosystème intégré, et qui rassemble des acteurs proéminents de l’industrie, propose une solution viable aux entreprises qui cherchent à exploiter l’IA pour diverses applications.