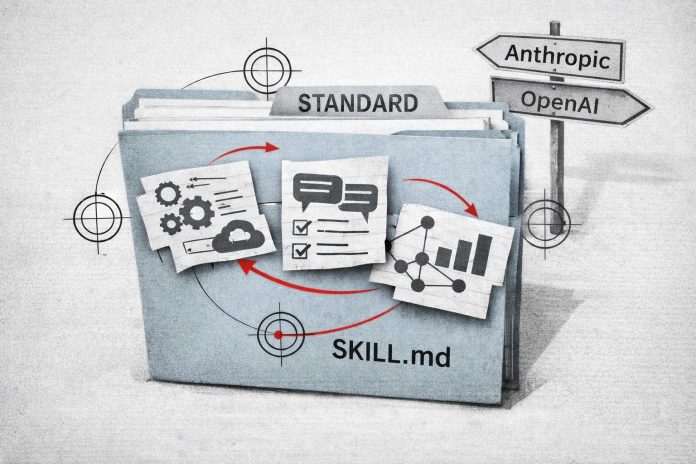

OpenAI et Anthropic prennent désormais en charge un même format décrivant les compétences des agents IA, matérialisé par le fichier Skill.md, un manifeste Markdown enrichi de métadonnées YAML qui documente fonctions, dépendances et conditions d’exécution. Cette convergence introduit la portabilité de capacités automatisées entre environnements concurrents et transforme des outils spécifiques en composants versionnés réutilisables.

La description normalisée d’une compétence d’agent repose sur une structure déclarative comprenant un en-tête YAML lisible par la machine et un corps Markdown destiné aux instructions opérationnelles. La documentation développeur d’Anthropic précise que ce fichier constitue « l’unité racine d’un skill » et qu’il doit regrouper les éléments nécessaires à son exécution dans un répertoire unique. Cette formalisation transforme une suite d’invites ou de scripts en module identifiable, versionnable et distribuable, comparable à un paquet logiciel.

OpenAI a parallèlement introduit dans son API Responses des mécanismes destinés à exécuter ces modules dans des conditions stables. La plateforme indique que les agents peuvent fonctionner dans des conteneurs hébergés disposant d’un environnement Debian 12 complet, avec stockage persistant et accès réseau contrôlé. Cette capacité rapproche l’agent d’un processus applicatif classique, capable d’opérer sur la durée plutôt que de répondre à une requête isolée.

Un manifeste qui décrit les capacités exécutables

Le fichier Skill.md agit comme une interface contractuelle entre le modèle et l’environnement d’exécution. Les métadonnées YAML précisent le nom de la compétence, les outils requis, les paramètres acceptés et les règles d’appel, ce qui permet à une plateforme compatible d’interpréter automatiquement ce qu’un agent peut faire sans réécriture spécifique. Cette description explicite réduit les ambiguïtés d’intégration et permet aux équipes techniques de tracer précisément les actions automatisées dans leurs systèmes.

Cette approche introduit une séparation nette entre le modèle de langage et les fonctions qu’il orchestre. Là où un agent était auparavant construit sur mesure pour une plateforme donnée, la compétence devient un artefact autonome que l’on peut déplacer, auditer et mettre à jour indépendamment. Ce découplage rapproche l’IA des standards d’API ou des conteneurs applicatifs qui ont permis l’industrialisation du cloud au cours de la décennie précédente.

Des environnements d’exécution pour usages longue durée

Les nouveaux mécanismes introduits par OpenAI répondent à une contrainte identifiée dans les déploiements d’agents, à savoir la perte de contexte lors d’exécutions prolongées. La fonction dite de compaction côté serveur condense l’historique conversationnel afin de maintenir la continuité logique tout en limitant la consommation de mémoire. Ce procédé permet à un agent de fonctionner pendant plusieurs heures sans dérive sémantique, condition nécessaire pour des processus métiers continus.

L’exécution dans des conteneurs dédiés ajoute une isolation comparable à celle d’une machine virtuelle légère. Chaque agent dispose de son propre espace système, ce qui facilite l’intégration avec des outils internes tout en permettant aux équipes de sécurité d’appliquer des politiques de contrôle réseau, de journalisation et de gestion des accès conformes aux pratiques DevSecOps.

La diffusion de catalogues communautaires de compétences est déjà amorcée avec des modules distribués comme des extensions logicielles. Plusieurs milliers de compétences sont déjà recensées sur des plateformes d’hébergement spécialisées, signalant l’apparition d’un écosystème de réutilisation qui dépasse le cadre d’un seul fournisseur.

Une évolution qui déplace la valeur vers des actifs logiciels métier

La standardisation d’un format descriptif transforme une expertise automatisée en composant transférable. Pour les utilisateurs, cela signifie qu’une capacité développée pour un cas d’usage interne peut être redéployée sur une autre infrastructure compatible sans reconstruction complète. Cette portabilité réduit l’effet de dépendance à une plateforme unique et facilite l’alignement avec des stratégies d’architecture multi-fournisseurs.

Elle introduit également de nouvelles responsabilités de gouvernance. Chaque compétence devient un élément de la chaîne d’approvisionnement logicielle qu’il faut qualifier, maintenir et sécuriser, au même titre qu’une bibliothèque open source. Les équipes RSSI devront donc intégrer ces modules dans leurs processus d’audit, de gestion des versions et de contrôle des dépendances.

Cette convergence technique ne constitue pas encore une normalisation formelle pilotée par un organisme de standardisation, mais elle marque une étape vers l’industrialisation des agents IA. En décrivant leurs capacités comme des composants logiciels autonomes, les plateformes amorcent un modèle où l’expertise automatisée devient un actif versionné, déployable et gouvernable selon les mêmes principes que les applications d’entreprise.