Une interface low-code est une partie d'un logiciel ou d'une application qui permet aux utilisateurs de créer ou de modifier des applications avec un minimum de code. Elle utilise souvent des outils visuels, tels que des glisser-déposer, des modèles préconstruits et des éditeurs WYSIWYG (What You See Is What You Get). Un environnement ou une plateforme de développement low-code est un cadre complet qui permet de développer, tester, déployer et gérer des applications avec un minimum de code. Ces plateformes offrent une suite d'outils et de services intégrés pour le cycle de vie complet du développement d'applications.

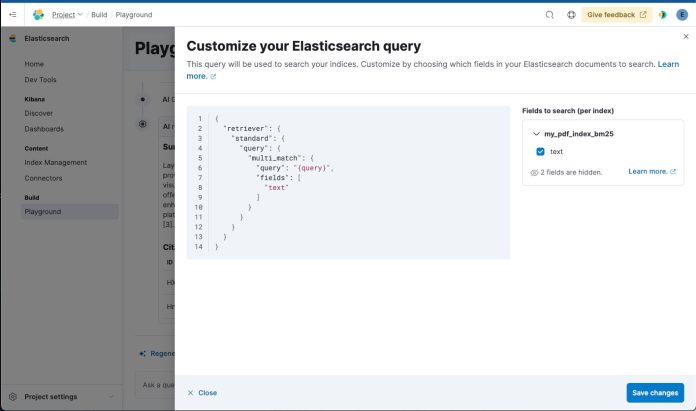

Playground facilite donc les expérimentations rapides et les itérations avec les composants essentiels des workflows de RAG (Retrieval-Augmented Generation). Playground est conçu pour être facile à utiliser, même pour les développeurs qui ne sont pas des experts de RAG. Il fournit une interface visuelle pour construire et tester des applications RAG.

RAG est un modèle de langage qui combine les avantages des méthodes de récupération d'informations traditionnelles et des modèles de génération de langage. Il utilise un index Elasticsearch pour stocker des vecteurs denses et effectuer des recherches de voisinage les plus proches pour chaque requête. Cette approche permet au modèle de générer des réponses plus précises et contextuellement pertinentes.

Les documents sont encodés en vecteurs denses à l'aide d'un modèle de langage pré-entraîné, ce qui permet de mesurer la similarité sémantique entre les documents et les requêtes en calculant la distance entre leurs vecteurs dans l'espace de représentation. Cette approche permet de récupérer des informations plus précises, même si les requêtes ne contiennent pas les mêmes mots-clés que les documents.

Intègre les modèles transformateurs dans Elasticsearch

L’une des caractéristiques principales de Playground est son interface intuitive pour tester les modèles de langage, permettant aux utilisateurs de comparer les performances de divers LLM. Il permet de tester différents modèles de langage de fournisseurs tels qu’OpenAI et Anthropic, en ancrant les réponses dans les données de l’utilisateur indexées dans Elasticsearch. Grâce à une recherche hybride et contextuelle, Playground combine des données vectorielles et textuelles pour maximiser la pertinence des réponses.La solution intègre des modèles transformateurs directement dans Elasticsearch, générant des requêtes unifiées qui maximisent la pertinence des réponses. Les utilisateurs peuvent ainsi bénéficier d’une recherche sémantique améliorée. De plus, il supporte divers modèles d’indexation, comme BM25 et les modèles d'embedding textuel tels que ELSER, pour l’importation et la transformation des documents afin d’optimiser la recherche sémantique.

Playground propose également des pipelines d'ingénierie et d'inférence personnalisés pour l’indexation des données vectorielles. Le processus est automatisé, simplifiant ainsi l’intégration et l’optimisation des données. Accessible via Kibana, il permet de connecter des modèles de chat comme GPT-4, offrant une expérience utilisateur enrichie par des stratégies de chunking et de recherche sémantique. Les réponses des LLM sont ainsi améliorées en termes de précision et de pertinence.

Enfin, Playground simplifie l'optimisation des prompts et des méthodes de récupération pour améliorer les réponses des LLM, permettant ainsi une intégration facile dans des applications tierces via des clients Python Elasticsearch ou des intégrations LangChain.