L’adoption du digital affiche parfois des revers inattendus… Ainsi les algorithmes américains de police prédictive, dont l’objectif est de prédire les crimes, favorisent et amplifient au contraire les actions d’une police perçue comme raciste.

Plusieurs villes américaines - Los Angeles, Atlanta, Philadelphie, etc. - ont adopté des algorithmes reposant principalement aujourd’hui sur les Big Data analytiques, qui visent à déterminer les ‘hotspots’ à risque, les lieux où le crime affiche une forte probabilité d’arriver.

La principale solution s’appelle PredPol. Elle repose sur un algorithme qui a été développé par le département de la police de Los Angeles, en collaboration avec les universités locales. Les modèles sont destinés à donner une vision des lieux où le crime est censé être. Dans la réalité, les résultats obtenus en font plutôt un outil de validation des décisions de la police…

Un test aux résultats effrayants

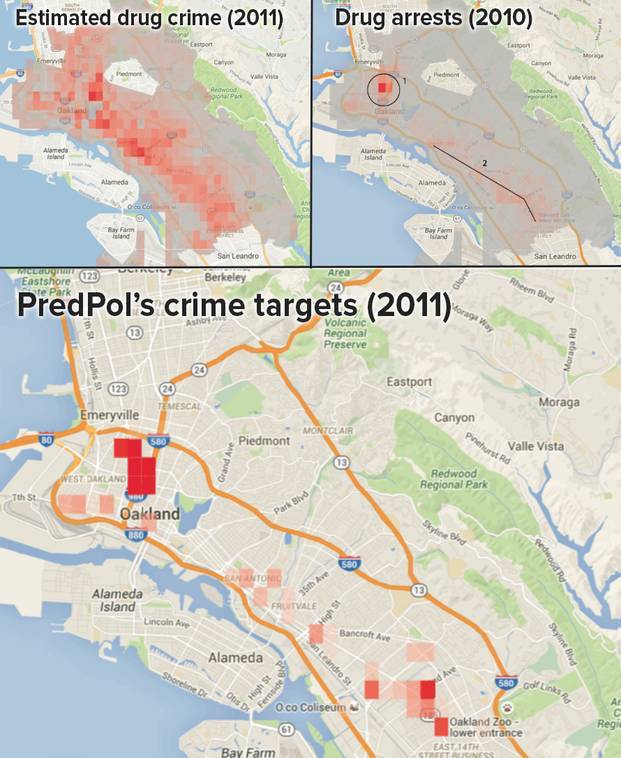

Les chercheurs du Data Analysis Group Human Rights – une organisation à but non lucratif dédiée à l'utilisation de la science pour analyser les violations des droits de l'homme dans le monde entier – ont appliqué l'outil sur la criminalité de la ville d’Oakland. L'algorithme a recommandé à la police de déployer des agents dans les quartiers avec des résidents noirs pour la plupart.

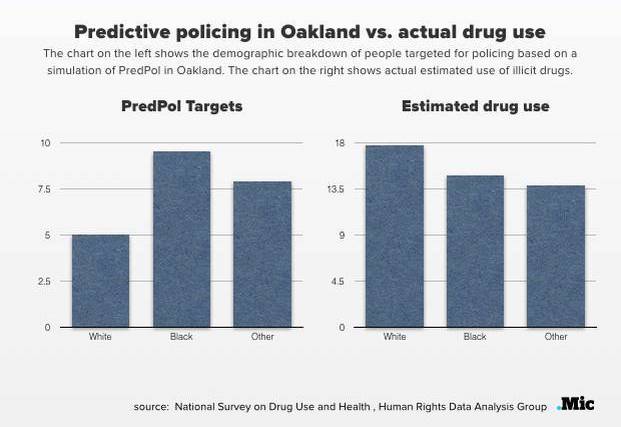

Alors que sur Oakland, les Blancs consomment des substances illicites à des taux plus élevés que les minorités, les interventions et arrestations de la police sont environ 200 fois supérieures dans les quartiers noirs que dans les autres quartiers. Ce qui signifie que la police intervient peu dans les quartiers où se concentre le crime de drogue, c’est à dire partout !

Or, la solution PredPol a préconisé des déploiements de forces de police qui sont quasi identiques à ceux qui se déroulent dans la réalité, c’est à dire concentrés une nouvelle fois sur les quartiers noirs ! Un résultat qui est à rapprocher de l’objectif de PredPol, décider sur quels quartiers ou blocs les officiers de police doivent porter leur priorité. C’est ainsi que, comme le montre le schéma ci-dessous, les cibles identifiées par l’algorithme sont bien différentes de l’estimation de la consommation de drogue.

La boucle de rétroaction favorise le racisme policier

Le résultat est la création d’une boucle de rétroaction : la solution exploite une ‘carte de chaleur’ quantifiant les lieux où le crime est déclaré et où se déroulent les arrestations, sur lesquels sont envoyées les forces de police, là où se concentrent déjà les arrestations. Ce qui crée des lieux sur-policés, et favorise à la fois les excès, les dérives comme celles qui font la une des journaux américains, et le racisme.

Et lorsque l’on vous parle de boucle de rétroaction, l’image va plus loin encore. Certaines villes américaines qui exploitaient des PredPol, comme Richmond et Burbank, ont fini par l’abandonner. En cause, le morale de 75 % des officiers de police en berne ! Ces villes n’ont pas mesuré l’effet sur l’humain d’être dirigés par des algorithmes… Elles reprochent également à l’éditeur de la solution son absence de transparence. Comment fonctionne l’algorithme ? La concentration sur la population noire est-elle volontairement raciste ? Seuls les experts mandatés par PredPol sont autorisés à analyser le code.

Prenant la mesure du phénomène, certains Etats américains comme l’Illinois ont légiféré afin d’interdire l’usage de systèmes ayant un impact racial. La technologie doit rendre les villes plus efficaces et où il fait bon vivre. Un algorithme ne doit pas rendre la ville invivable...

Image d’entête 70244865 @ iStock Dezein