Avec le développement massif des Objets de l’Internet et des services Cloud éclatés, la pertinence tant de la collecte des informations que de leur traitement efficace et rapide nécessite une « présence » que seule l’Intelligence Artificielle peut assurer. Plongée au cœur du Edge Computing

L’Informatique est une histoire de cycle. Du traitement centralisé sur mainframe, on est passé à l’ère du Client-Serveur en mode distribué puis à la révolution du distribué partout, tout le temps et à n’importe quel moment avec le Cloud. Une double révolution avec la modification concomitante du business model désormais axé sur les services. Et aujourd’hui, c’est le tour du Edge, un nouveau marché en pleine explosion en termes de chiffres avec l’Edge Computing. La philosophie de cette tendance est d’effectuer le traitement au plus proche de la donnée, voire même où elle est collectée. De nombreuses raisons sont avancées à cela, notamment l’augmentation de problèmes générés par beaucoup de consommation de puissance dans le Cloud du fait de calculs lourds et également des soucis de connectivité qui entraînent des temps de latence ce qui complique la fourniture d’un service. Précurseurs de cette infrastructure Edge, les Apple, Tesla et Amazone ont imaginé et appliqué la notion de micro-datacenter en en distribuant l’architecture de traitement auprès de l’endroit où la donnée est générée. L’idée est de résoudre les problèmes générés par la forte demande d’IoT, de plus en plus intelligents et générateurs de nombreuses données.

Flot d’IoT + Flux de données = IA at Edge

Du fait de l’explosion des IoT, destinés au monde de la consommation comme au milieu industriel, et notamment de l’intelligence de ces appareils, il est de plus en plus nécessaire de trouver des solutions afin de réduire toutes sortes de coûts, avec des économies de puissance et de bande passante, la diminution des temps de latence induits et également l’augmentation de la sécurité des données générées par ces appareils (smartphones, voitures connectées ...). Sans compter que l’expérience utilisateur est un des points forts de ce marché et le temps de réponse doit donc se rapprocher du Temps Réel pour correspondre à leurs besoins.

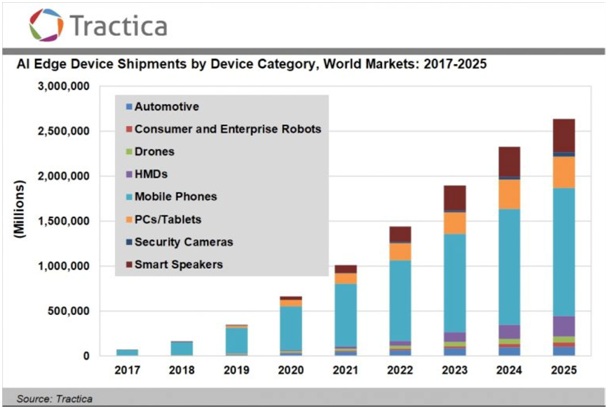

Un marché d’appareils intelligents estimé à 161, 4 millions en 2018 et qui devrait passer à 2,6 milliards d’appareils dans le monde d’ici à 2025 selon Tractica. C’est un marché très varié comme le démontre le schéma proposé parle cabinet d’analyses.

IA à la source

Pour obtenir du temps réel en termes de réponse, rien de mieux que « l’AI at the Edge », suite logique du Edge Computing. Cela impose la présence d’algorithmes de Machine Learning installés en local, et qui tournent sans connexion réseau. Une répartition rendue possible car il existe deux sortes d’algorithmes d’Intelligence Artificielle. La plupart du temps, les traitements réalisés dans le Cloud sont gourmands en temps de calcul car cela correspond à l’entraînement des modèles de Deep Learning qui créeront le phénomène « Intelligence Artificielle » au sein des programmes. Cependant, Il existe une portion de l’algorithme AI, le « AI Inference » beaucoup moins demandeuse en termes de puissance machine et dont le traitement peut donc se faire en local là où sont générées les données.

Du fait d’un nombre croissant d’applications AI, le déplacement du traitement de la partie Inférence sur l’appareil devient même indispensable. Et ce, même si, rappelle Tractica, cela dépend étroitement de la nature de l’application AI comme celle de l’Objet considéré.

AI au sein du Microcontrôleur

Concrètement comment réaliser ce nouveau tour de passe passe? Pour que l’Edge Computing puisse exister, il a déjà fallu utiliser beaucoup de matériel de calcul et notamment de CPU, GPU, Asics, FGPA, ou SoC accelerator. Parallèlement la réduction des modèles d’intelligence Artificielle est à l’ordre du jour et certains comme Google avec Learn2compress s’y sont attaqués. Cela permet d’envisager de les faire tourner sur de plus petits matériels physiques.

Là intervient le microcontrôleur, sorte de microprocesseur en plus petit, possédant sa propre puissance de calcul, sa mémoire également et son lot d’entrées/sorties. Le tout ne consomme pas plus de quelques microwatts affirme Joël Rubino, l’un des fondateurs de la société française Cartesiam, spécialisée dans le domaine. L’intérêt du microcontrôleur est que l’on peut le coupler avec des capteurs sur un IoT. Les impulsions reçues par le capteur génère des données qui sont alors directement exploitées par le microcontrôleur.

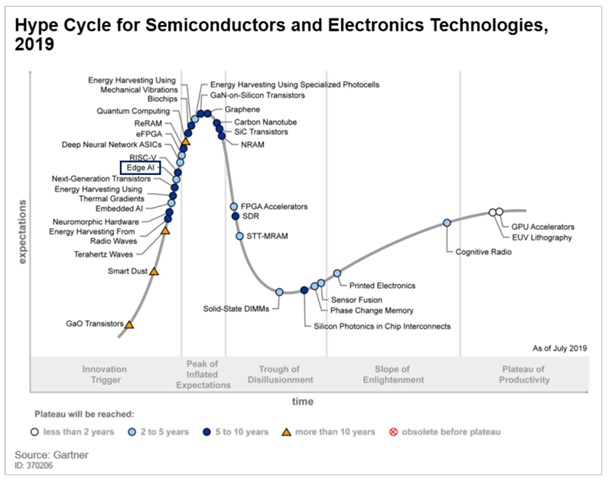

Et des microcontrôleurs, on en trouve partout : pas moins de 15 milliards vendus chaque année, de la cafetière à la voiture (50 à 100 sur ce type d’Objet). Il est donc possible de prendre des décisions rapidement en Edge. Un nouveau marché que le Gartner affiche dans son « Hype Cycle » qui détermine les technologies de Semi-conducteurs et d’électroniques de Demain. Notamment dans la catégorie Advanced Analytics, l’on retrouve l’Edge AI. Et aux côtés de deux géants de l’industrie des semi-conducteurs, STMicroelectronics et Renesas Electronics, la surprise avec une petite startup française, Cartesiam, totalement dans le software pour son cas.

Cartesiam, dans la cour des grands

Elle a créé « NanoEdge AI », une fonction AI directement installée à l’intérieur du microcontrôleur. Le moteur IA embarqué dans cette solution évolue en auto-apprenant et n’a donc pas besoin de jeux de données ou de Data Scientist pour ce faire. Il s’appuie sur les données générées par le ou les capteurs situés sur l’IoT. Une prise de décision peut donc se prendre en local pour faire de la maintenance prédictive, par exemple ou pour d’autres, imaginer un modèle qui travaille sur des signaux. Leur solution est restée en Recherche et Développement pendant trois avant de voir le jour puis de se retrouve dans le Hype Cycle 2019 for Semiconductors and Electronics Technologies du Gartner.