Avec Open Lakehouse, Qlik muscle sa plateforme cloud en intégrant un socle Iceberg géré, interrogeable par plusieurs moteurs, et conçu pour accélérer les usages IA. La solution cible les entreprises souhaitant échapper aux silos propriétaires tout en maîtrisant les coûts, la performance et la gouvernance.

La vague de l’intelligence artificielle remet en question l’architecture traditionnelle des données en entreprise. Face à des lacs de données souvent fragmentés, figés ou surdimensionnés, de nouveaux modèles émergent autour des formats ouverts, de la gouvernance unifiée et de l’orchestration en temps réel. C’est dans cette dynamique que s’inscrit Qlik avec la disponibilité générale de sa solution Open Lakehouse, basée sur Apache Iceberg, et conçue pour fonctionner en environnement multi-moteurs. Un socle ouvert, déployé chez le client, prêt pour l’IA.

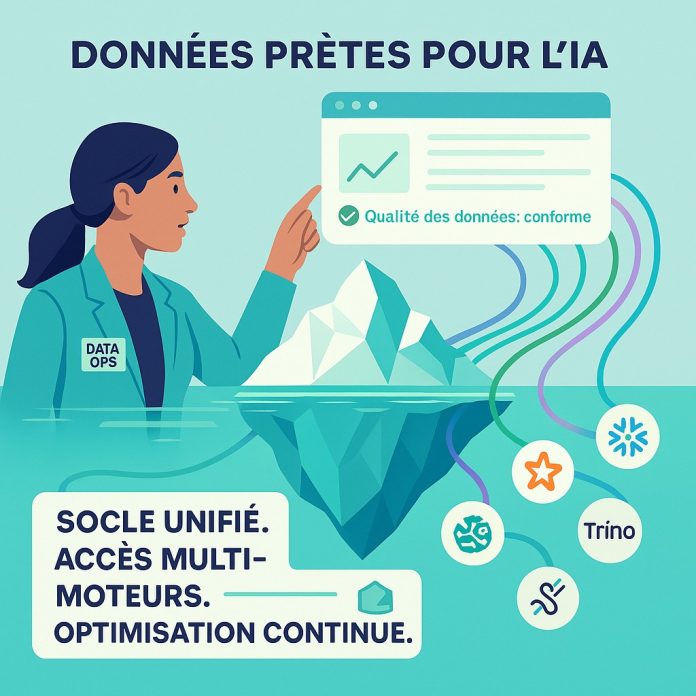

Intégré à la plateforme Qlik Talend Cloud, le service Open Lakehouse est désormais accessible à l’ensemble des clients, avec un déploiement dans leur propre cloud privé. Qlik revendique un modèle « bring-your-own-compute » où les données restent dans le stockage objet du client, tandis que les traitements sont opérés à l’aide des outils de leur choix : Amazon Athena, Snowflake, Trino, Spark ou SageMaker pour l’apprentissage automatique.

Cette approche a pour but de concilier la souveraineté, l’interopérabilité et la performances : les données sont stockées dans des tables Iceberg gouvernées, constamment mises à jour via des pipelines en capture de changement (CDC), puis interrogées sans duplication par des moteurs analytiques ou de machine learning. L’optimisation automatique d’Iceberg (compression, partitionnement, métadonnées) complète le dispositif en réduisant les coûts de stockage tout en améliorant la latence des requêtes.

Réduction des coûts et fin des silos propriétaires

Qlik revendique une amélioration significative des temps de réponse et une baisse jusqu’à 50 % des coûts d’infrastructure chez les premiers clients, qui ont profité d’une migration progressive depuis leurs entrepôts de données classiques vers un socle Iceberg unifié, l’enjeu étant de s’affranchir des formats fermés ou des solutions surdimensionnées, souvent incompatibles avec les workflows IA distribués. Le positionnement de Qlik Open Lakehouse marque ainsi en rupture avec les approches verrouillées, en promouvant un modèle d’orchestration interopérable fondé sur les standards du cloud.

Pour Mike Capone, PDG de Qlik, « lorsque les données sont lentes, fragmentées et coûteuses, l’IA piétine. » La promesse ici est d’apporter aux équipes métiers et aux data scientistes un socle unifié, rapide et activable dans leurs outils natifs, sans avoir à réinventer leur stack technique ni sacrifier la gouvernance.

Un signal fort dans la bataille du Lakehouse managé

En se positionnant sur un service managé Iceberg nativement intégré à une suite analytique et à des outils de qualité de données, Qlik entend rivaliser avec des acteurs comme Snowflake, Databricks ou Google BigLake, qui multiplient les passerelles vers le format Iceberg tout en conservant leurs environnements propriétaires. La différence mise en avant par Qlik : la combinaison entre un pilotage natif dans le cloud du client, un accès multi-moteurs dès le premier jour, et une automatisation intégrée (optimisation, qualité, traçabilité, FinOps).

Pour les entreprises engagées dans des trajectoires IA, cette évolution marque une étape importante. L’alignement entre gouvernance des données, accessibilité multi-usage et interopérabilité devient un critère central dans le choix d’une plateforme. Comme le souligne Mike Leone, analyste chez ESG : « Qlik fournit une plateforme robuste que les équipes peuvent adopter sans avoir à repenser entièrement leurs systèmes ou à changer d’outils. »

Une orchestration de plus en plus contextuelle et agnostique

Cette annonce confirme la tendance à la contextualisation fine des flux analytiques : les moteurs d’analyse ou d’apprentissage n’ont plus à attendre que les données soient extraites, recopiées, puis retraitées. Grâce à l’intégration directe avec SageMaker, Open Lakehouse permet aux équipes IA de préparer et d’entraîner leurs modèles directement sur des tables Iceberg, à jour et gouvernées, dans le respect des normes AWS. À terme, cette logique de traitement in situ pourrait favoriser l’émergence de plateformes de traitement événementiel et d’agents analytiques déclenchant automatiquement des actions métier à partir d’anomalies ou de prévisions détectées.

La bataille pour le contrôle de l’orchestration des données ne fait que commencer. Qlik Open Lakehouse s’impose comme une brique stratégique de cette recomposition, en misant sur l’ouverture, la vitesse et la sobriété comme leviers d’adoption.