Face à la pression croissante des applications fondées sur l’intelligence artificielle – apprentissage automatique, modèles linguistiques, moteurs de recommandation – les architectures classiques atteignent rapidement leurs limites. Les grappes GPU traditionnelles, même interconnectées via des bus PCIe ou NVLink, souffrent de goulets d’étranglement lors du passage à l’échelle. C’est dans ce contexte que Huawei introduit SuperPoD, une architecture de calcul unifié où l’ensemble des composants matériels se comportent comme un serveur logique unique.

Le composant technique central de cette architecture est le protocole d’interconnexion UnifiedBus. Il permet de connecter de façon homogène les unités de calcul (NPU Ascend), la mémoire haute capacité et les modules de stockage NVMe, en s’affranchissant des barrières physiques traditionnelles. Selon Huawei, cette approche assure une latence réduite à 0,9 μs, une bande passante agrégée de 2 To/s et un partage dynamique de la mémoire sur l’ensemble du PoD, indépendamment de l’emplacement physique des ressources.

Cette structure logicielle et matérielle permet de découpler les couches de traitement – calcul, mémoire, E/S – pour offrir une mise en commun des ressources, sur le modèle des architectures désagrégées. Le protocole UnifiedBus est accompagné de son OS d’exécution, UB OS Component, désormais open source. Huawei a également ouvert les spécifications de l’interconnexion afin de faciliter l’intégration de partenaires ou d’acteurs tiers dans l’écosystème SuperPoD.

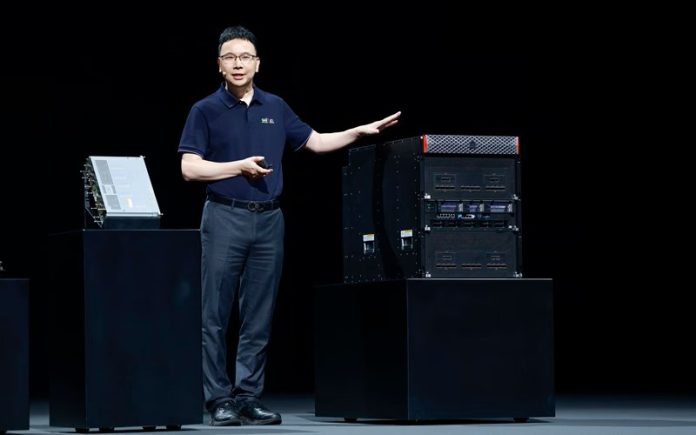

Une gamme complète de serveurs Ascend Atlas optimisée pour l’IA

Pour soutenir cette architecture, Huawei a présenté une nouvelle génération de serveurs et cartes IA dans sa gamme Atlas. Le modèle phare, l’Atlas 950, repose sur une conception à refroidissement liquide capable de contenir jusqu’à 512 NPU Ascend. Ce modèle cohabite avec les Atlas 850 (air) et Atlas 860 (liquide), selon les contraintes thermiques et énergétiques des centres de données.Les cartes Atlas 350, dotées de l’unité Ascend 910B ou 950PR, forment l’unité de calcul de base. Ces modules exploitent une mémoire LPDDR de grande capacité, une interconnexion multi-ligne (bus logique 64×) et des interfaces PCIe Gen5 ou CXL, selon les usages. L’ensemble est intégré à une baie ou un rack préconfiguré, avec supervision logicielle complète via MindX DL et outils d’orchestration CANN (Compute Architecture for Neural Networks).

Un rendement IA supérieur aux plateformes concurrentes, selon Huawei

Huawei revendique une amélioration linéaire du rendement IA par rapport aux architectures existantes. Dans une configuration SuperPoD Atlas 950 de 512 NPU, les performances en entraînement de modèle dépasseraient celles d’un cluster NVL144 (plateforme concurrente NVIDIA). Le fabricant met en avant une efficacité énergétique améliorée, une densité mémoire supérieure (grâce à la mutualisation) et une simplification de l'orchestration.L’architecture autorise également l’exécution conjointe de différentes charges : inférence de grands modèles, fine-tuning, IA conversationnelle, gestion vectorielle, entraînement de modèles open source. Selon Huawei, SuperPoD est compatible avec de nombreux frameworks, dont PyTorch, MindSpore, TensorFlow, ainsi qu’avec les formats de modèles Pangu, Llama 2 et autres fondations open source.

Une feuille de route claire pour l’ascension des puces Ascend

Lors de son discours d’ouverture, Eric Xu a dévoilé une roadmap détaillée des futures puces Ascend, jusqu’à la génération 970 prévue fin 2028. Chacune apportera une augmentation des capacités d’interconnexion, de bande passante mémoire, de prise en charge de nouveaux formats numériques (BF16, INT4, 2bit), et d’efficacité énergétique. Le cycle de lancement prévoit un nouveau processeur tous les 18 mois, avec compatibilité logicielle maintenue.Ce calendrier rassure sur la pérennité de l’écosystème Ascend, qui s’appuie désormais sur des standards internes ouverts et des briques logicielles partagées. Huawei confirme par ailleurs que l’ensemble des logiciels d’entraînement, de gestion de cluster et d’orchestration IA seront progressivement placés en open source, avec supervision assurée par des fondations dédiées.

Un socle technique pour exécuter l’IA à l’échelle industrielle

SuperPoD représente une tentative ambitieuse de repenser le calcul haute performance à l’ère de l’IA. Là où les fournisseurs classiques ajoutent des couches pour masquer les contraintes matérielles, Huawei propose une unification structurelle du calcul, de la mémoire et du réseau. Cette approche désagrégée mais logique permet d’exécuter plus efficacement les flux IA modernes, tout en offrant aux entreprises un levier d’optimisation énergétique, fonctionnelle et financière.Reste à observer comment ces architectures seront déployées en production en dehors du marché domestique chinois, et si UnifiedBus deviendra un standard reconnu par l’industrie ou un protocole fermé autour de l’écosystème Ascend. Dans les deux cas, Huawei marque un point stratégique dans la compétition autour du calcul IA à très grande échelle.