À l’occasion de la sortie du Community Standards Enforcement Report, le rapport sur l’état de la lutte des réseaux sociaux (Facebook et Instagram) contre les contenus qui enfreignent sa politique (fake news, harcèlement…), et lors d’une conférence téléphonique avec les journalistes, Guy Rosen, Vice President of Integrity chez Facebbok, a reconnu que le réseau social avait de plus en plus recours à l’IA pour modérer les contenus sur Facebook et Instagram.

« Pour protéger la santé et la sécurité de notre personnel, en mars nous avons renvoyé chez eux tous nos modérateurs de contenus. Nous avons ensuite mené deux actions parallèles : la première a consisté à permettre à nos modérateurs de travailler autant que possible à domicile et la seconde à s’appuyer davantage sur notre technologie pour examiner le contenu. Nous avons accéléré certains travaux déjà en cours pour réorganiser notre système de surveillance des contenus », affirmait-il en préambule à son intervention.

Une série de mesures pour faire taire les critiques

Dans ce rapport d’août 2020, Facebook fait le bilan du second trimestre, d’avril à juin 2020, de ses efforts et des mesures prises pour prévenir les contenus qui enfreignent ses politiques. Signalons que, suite aux critiques venant de toute part, le réseau social avait fini par adopter une série de mesures qui lui permettraient d’affiner la modération des contenus dans le respect de la liberté d’expression.

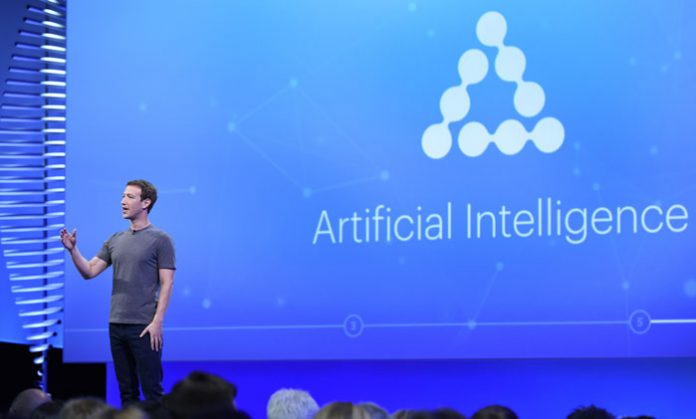

Notamment la mise en place, en mai dernier, d’un Conseil de surveillance, une espèce de haut comité de relecture, chargé de trancher les cas les plus difficiles et les plus importants concernant les contenus. Comme l’affirmait Mark Zuckerberg son PDG, un adepte inconditionnel de la liberté d’expression : « Facebook ne devrait pas prendre seul autant de décisions importantes concernant la liberté d’expression et la sécurité ».

L’IA en première ligne pour traiter les contenus litigieux

Mais avant que les cas les plus difficiles n’atterrissent sur la table du Conseil, il sera d’abord classifié par l’IA, puis passera par les fourches caudines des modérateurs. « Nous utilisons maintenant l’intelligence artificielle pour créer un classement des contenus les plus critiques que nos équipes doivent modérer, annonçait Guy Rosen. Qu’ils aient été signalés par les utilisateurs ou détectés par un système proactif. Cela permet à notre équipe de passer son temps sur les cas où nous avons le plus besoin de son expertise. Et cela signifie qu’il y aura une évolution vers un plus grand nombre de contenus qui seront initialement traités par nos systèmes automatisés ».

Dans une communication datant du 11 août dernier, Jeff King, Director Product Management, Integrity et Kate Gotimer, Director, Global Operations, donnaient plus de détails sur la technologie utilisée et son mode de fonctionnement. L’IA de Facebook s’appuie sur les données d’apprentissage issues des différents cas traités par les modérateurs, afin d’identifier des modèles de comportement significatifs et de trouver des contenus potentiellement violents. « C’est pourquoi notre système d’examen du contenu a besoin à la fois de personnes et de technologies pour réussir, écrivaient les auteurs de l’article. Nos équipes se concentrent sur les cas où il est essentiel de faire appel à des modérateurs et nous utilisons la technologie pour nous aider à étendre nos efforts dans les domaines où elle peut être la plus efficace ».

Comment fonctionne le processus automatisé selon Facebook

Détection proactive : L’intelligence artificielle (IA) s’est améliorée au point de pouvoir détecter les violations dans un grand nombre de domaines sans avoir à compter sur les utilisateurs pour signaler le contenu à Facebook, souvent avec une plus grande précision que les rapports des utilisateurs. Cela nous permet de détecter les contenus préjudiciables et d’empêcher qu’ils soient vus par des centaines ou des milliers de personnes.

Automatisation : L’IA a également permis d’étendre le travail de nos modérateurs de contenu. Nos systèmes d’IA automatisent les décisions pour certains domaines où les contenus sont très susceptibles d’être violés. Cela permet d’adapter les décisions relatives au contenu sans sacrifier la précision, de sorte que nos modérateurs peuvent se concentrer sur les décisions qui nécessitent une plus grande expertise pour comprendre le contexte et les nuances d’une situation particulière. L’automatisation permet également de prendre plus facilement des mesures sur des rapports identiques, de sorte que nos équipes n’ont pas à passer du temps à examiner plusieurs fois les mêmes choses. Ces systèmes sont devenus encore plus importants pendant la pandémie de Covid-19, avec un personnel chargé de la révision du contenu en grande partie à distance.

Établissement de priorités : Au lieu de se contenter d’examiner les contenus signalés dans l’ordre chronologique, notre IA classe par ordre de priorité les contenus les plus critiques à examiner, qu’ils nous aient été signalés ou qu’ils aient été détectés par nos systèmes proactifs. Ce système de classement priorise les contenus les plus préjudiciables aux utilisateurs en fonction de multiples facteurs tels que la viralité, la gravité du préjudice et la probabilité de violation. Si nos systèmes sont quasiment sûrs qu’un contenu enfreint nos règles, ils peuvent le supprimer. Dans le cas contraire, il donnera la priorité au contenu que les équipes devront modérer.