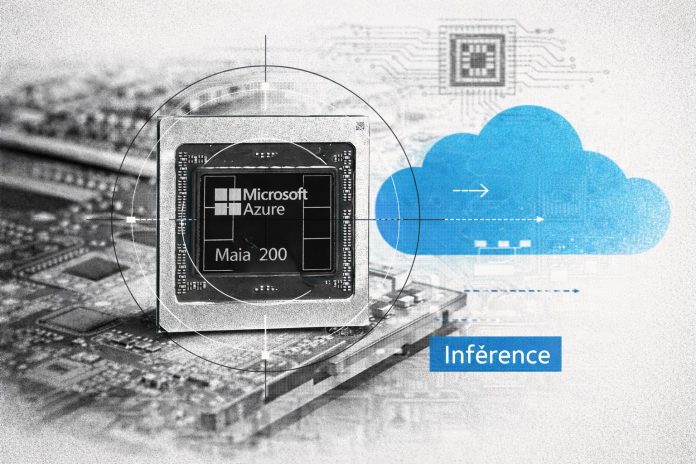

Microsoft a officialisé Maia 200, sa nouvelle puce dédiée à l’inférence IA, destinée à équiper les centres de données Azure et à améliorer la performance des applications d’intelligence artificielle dans le cloud. Ce lancement marque une étape dans la stratégie de l’éditeur visant à s’aligner sur les approches verticales déjà adoptées par Google et AWS, en développant des circuits propriétaires parfaitement intégrés à leur offre cloud.

La maîtrise du silicium redevient un axe stratégique dans la compétition mondiale autour de l’intelligence artificielle, alors que l’infrastructure des grands fournisseurs cloud évolue vers des plateformes intégrées, capables de soutenir des charges d’inférence massives à moindre coût. L’annonce par Microsoft de Maia 200, une puce d’inférence IA spécifiquement développée pour Azure, révèle une dynamique de réappropriation technologique initiée par Google et AWS, qui ont déjà imposé leurs propres accélérateurs propriétaires au cœur de leurs offres cloud. Ce mouvement traduit la volonté des géants du secteur de reprendre le contrôle sur les performances, les coûts et la flexibilité des services IA, tout en réduisant leur dépendance vis‑à‑vis de fournisseurs comme Nvidia.

La puce Maia 200 est gravée en 3 nm, embarque 105 milliards de transistors et 192 Go de mémoire HBM3e, avec une bande passante de 5 Tbit/s. Cette architecture, associée à une SRAM de 128 Mo, cible la réduction des goulets d’étranglement mémoire pour l’exécution des modèles volumineux et l’accélération du traitement des tokens. Les cœurs spécialisés FP4/FP8 privilégient l’efficacité énergétique et la rapidité sur les charges génératives. Maia 200 se déploie dans des cartes PCIe, avec une capacité de huit cartes par serveur Azure.

Microsoft s’aligne sur Google et AWS

Microsoft revendique des performances multipliées par trois sur le calcul FP4 et une amélioration de 30 % du ratio performance/coût par rapport aux accélérateurs existants dans Azure. La puce est livrée avec un SDK prenant en charge PyTorch et Triton, ce qui facilite l’optimisation des modèles et leur portage sur l’infrastructure Azure.

En lançant Maia 200, Microsoft rejoint Google et AWS, qui ont bâti leur domination sur l’IA autour de solutions matérielles propriétaires (TPU, Inferentia, Trainium) et d’une intégration verticale complète. La maîtrise du silicium devient un facteur de différenciation stratégique, non seulement pour sécuriser les approvisionnements, mais aussi pour proposer une plateforme cohérente du matériel jusqu’aux services gérés. Cette orientation vise à attirer les projets les plus exigeants en termes de coût, de puissance et de flexibilité, tout en limitant la dépendance à l’égard de Nvidia.

L’efficacité de Maia 200 reposera sur sa capacité à s’intégrer à l’écosystème logiciel de Microsoft, à soutenir l’ouverture vers des standards (Triton) et à offrir des avantages mesurables en production sur les tâches d’inférence. La démonstration de ce différenciateur se fera sur le terrain de l’adoption par les développeurs et les partenaires industriels.

L’industrialisation de l’inférence à moindre coût

Le choix d’une puce orientée exclusivement vers l’inférence traduit la volonté de Microsoft de répondre au principal poste de dépense des déploiements IA à grande échelle : le coût d’exploitation récurrent. L’optimisation du couple performance/énergie, la minimisation de la latence et l’intégration native dans la plateforme Azure visent à améliorer la rentabilité des usages industriels, du Copilot aux applications génératives personnalisées.

L’architecture de Maia 200 se démarque de celles des offres concurrentes par sa mémoire HBM3e ultra-rapide, sa gestion optimisée des flux de tokens et la granularité de ses capacités d’intégration (jusqu’à huit cartes par serveur, déploiement par grappes). Ce positionnement technique répond à la demande croissante des entreprises, des administrations et des fournisseurs de services pour des infrastructures IA capables d’industrialiser l’usage des modèles génératifs tout en contrôlant les coûts.

Intégration verticale et ouverture des standards

La bataille des plateformes IA se déplace du simple affrontement matériel vers la capacité à proposer un environnement ouvert, performant et économiquement pertinent. Maia 200 s’insère dans cette dynamique : l’ouverture à Triton, la compatibilité avec les principaux frameworks et l’optimisation des workflows DevOps et MLOps sont devenues des critères déterminants pour les décideurs IT.

Microsoft doit désormais démontrer que la convergence de son silicium, de ses outils de développement et de ses services cloud représente un avantage durable face à Google, AWS et Nvidia. Le succès de Maia 200 dépendra de l’adoption par les clients, du soutien des développeurs à l’écosystème logiciel Azure et de la capacité à délivrer des gains mlesurables en coût, en performance et en flexibilité.