L'enquête a interrogé plus de 1200 décideurs appartenant au secteur des banques, des fintechs, des prestataires de paiement et des compagnies d'assurance en Europe. Autant de cibles à forte valeur ajoutée pour les cybercriminels. Si les responsables ont bien intégré le problème constitué par les deepfakes (faux fichiers audio, images et vidéos), les lignes de défenses sont perfectibles, c’est un euphémisme. Les trois quarts des répondants mettent en avant les trois principaux freins à une posture de sécurité efficace

dans ce domaine.

D’une part, le manque d'expertise mentionné par 76 % des décideurs en matière de défense contre la fraude à l’identité. D’autre part, le manque de temps avec 74 % des membres du panel qui admettent n’avoir pas le temps de s'attaquer au problème dans les meilleurs délais. Enfin, le manque de budget indiqué par 76 % des décideurs déclarant qu’ils ne disposent pas de moyens suffisants pour déployer des technologies

de prévention de la fraude.

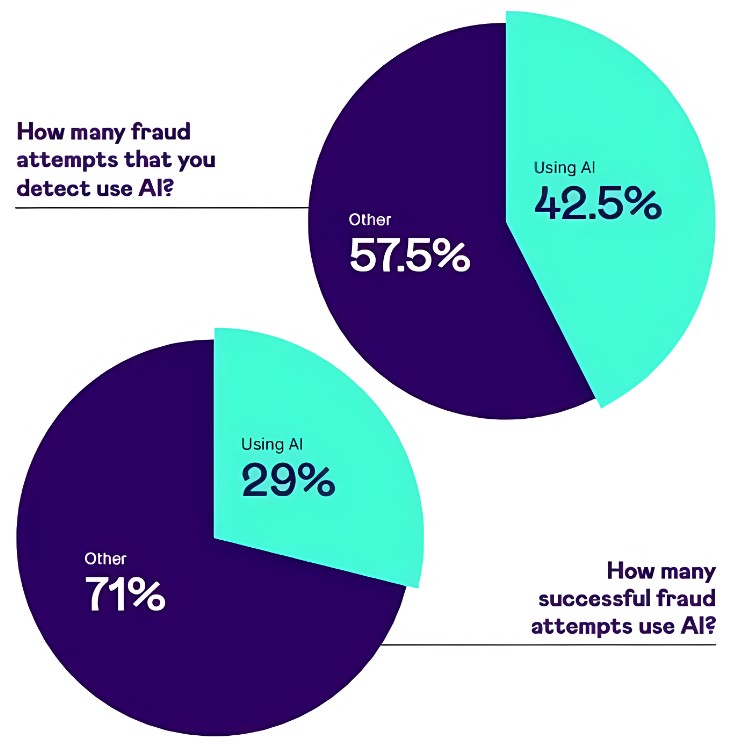

Aujourd’hui, les deepfakes et les attaques d'ingénierie sociale créées par une IA ont remplacé la génération semi-automatisée de fausses identités et de faux documents qui étaient en tête il y a trois ans. Le but étant la prise de contrôle des comptes utilisateurs pour les organisations B2B. Signicat estime que 42,5 % des tentatives de fraude détectées utilisent l'IA avec un taux de réussite préoccupant de 29 % d’attaques réussies.

Les secteurs les plus visés dans une proportion d’un tiers environ, sont les banques, les technologies financières (Fintech) et les grandes entreprises. Ce sont les cibles les plus intéressantes pour les groupes pirates, mais aussi les mieux protégées. Les deepfakes deviennent de plus en plus sophistiqués avec, aujourd’hui, des attaques par injection, à savoir l'insertion dans une application de vidéos ou messages audio manipulées et manipulatrice. Exit les grossières arnaques au Président qui ont été largement médiatisées il y a quelques années.

Utiliser une combinaison de techniques pour lutter efficacement contre les deepfakes

Les attaques de type deepfake ne représentaient que 0,1 % de toutes les tentatives de fraude il y a trois ans, mais elles s’établissent aujourd'hui à un taux de 6,5 %. Les techniques de protection contre ces menaces reposent sur le recours aux outils d’IAM, l’investissement dans la détection des menaces en temps réel et la sensibilisation du personnel. Ce dernier volet est essentiel, car les deepfakes visent à tromperla vigilance humaine.

Selon Signicat, les banques et les prestataires de services de paiement misent sur la robustesse des mots de passe, tandis que les assureurs et les fintechs préconisent d'autres mesures. En effet, ces derniers disposent d’informations précises sur les fraudes initiales (First-Party fraud). Il s’agit de falsifications d’identité commises par une personne ou une organisation afin d’obtenir des avantages financiers ou matériels.