Exploitant une centaine de milliers de milliards de paramètres pour ChatGpt4, les grands modèles de langage (LLM) des IA de nouvelle génération sont très gourmands en données et énergie. À plusieurs reprises, nous avons mentionné ce problème dans IT SOCIAL.

La consommation électrique d’un serveur à base de processeurs NVDIA DGX A100 est de 6,5 kWh et de 10,2 kWh pour les serveurs à base de DGX H100. Il faut traiter un nombre de paramètres croissant, en fonction de la nature des traitements, depuis la recherche en langage naturel jusqu’à la reconnaissance d’image.

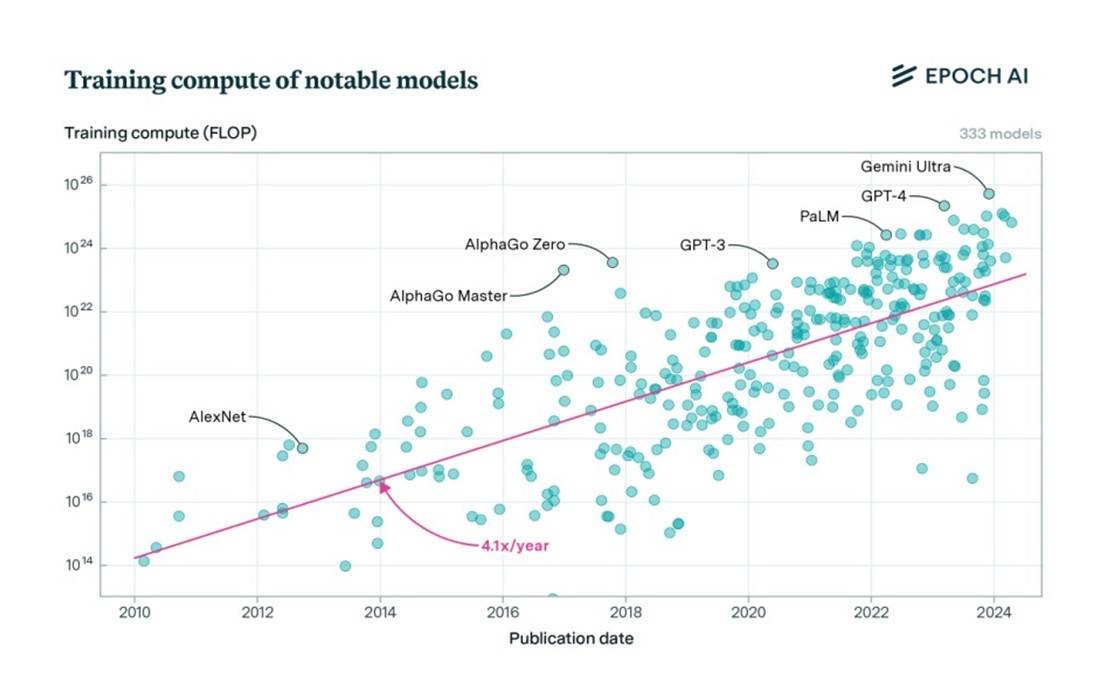

L’institut Epoch AI, qui se concentre sur l’évolution et la gouvernance de l’IA, a publié un rapport très instructif qui montre, notamment, que le calcul d'entraînement des modèles d'IA les plus avancés tels ChatGPT4 ou Gemini Ultra augmente de 4 à 5 fois par an. Selon Epoch AI, il est probable que cette croissance se maintienne dans un avenir proche, en l'absence de nouveaux goulets d'étranglement ou de grandes percées technologiques.

Pour mesurer les performances des différentes IA et IA génératives (IAGen), l’unité de mesure est le FLOP (nombre d’opérations en virgule flottante par seconde). Dans le graphique ci-dessous, la puissance de calcul figure en ordonnée en fonction des dates en abscisse. Constat explicite, les IAGen GPT-4 d’Open AI et Gemini Ultra de Google sont les plus puissantes et donc les plus gourmandes en énergie.

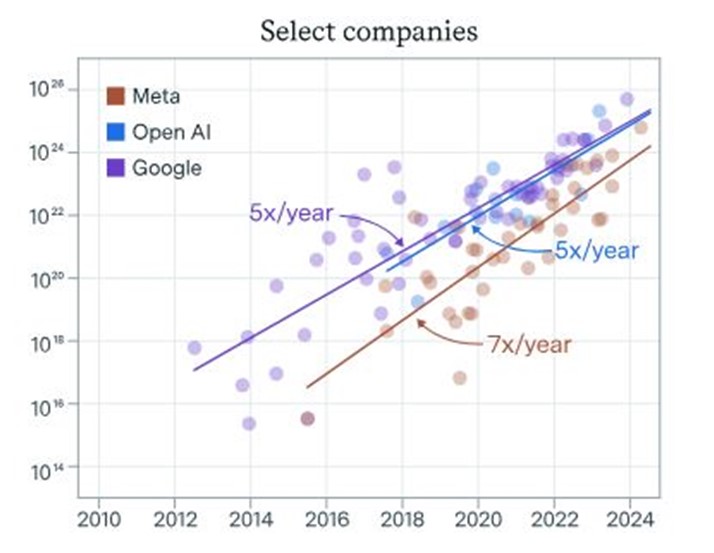

La croissance la plus importante est celle de l’IA de META (X7 par an) mais elle est suivie de près par celles d’Open Ai et Google (X5 par an pour les deux).

La croissance la plus importante est celle de l’IA de META (X7 par an) mais elle est suivie de près par celles d’Open Ai et Google (X5 par an pour les deux).

Les investissements pour l’entrainement des LLM et les tests seront de plus en plus lourds

Une autre étude de l’Institut Epoch AI estime que les modèles les plus avancés coûteront plus d'un milliard de dollars en développement d'ici à 2027. Cela concerne surtout la mise à disposition des équipements utilisés pour leur entraînement et les tests. Sachant que l’intégration de l’IA dans les processus des entreprises est une activité de niche, la question de la rentabilité se pose en termes crus.Selon les chiffres de BPI France, la taille du marché mondial de l’IA en 2023 était évaluée à 241 milliards de dollars et une prévision optimiste l’estime à 511,3 milliards de dollars d’ici 2027. Côté investissements, entre 2013 et 2022, les États-Unis, la Chine et la France ont respectivement investi des sommes colossales soit, respectivement, 248,9 milliards, 95,1 milliards, et 6,6 milliards de dollars. Reste à savoir si ces énormes investissements correspondent à un marché viable à terme.

Cela dit, Epoch AI indique que la croissance des modèles les plus avancés s'est ralentie et s'aligne désormais sur les tendances générales de l’IA. Prudemment, l’Institut note qu’il faut pondérer le mode de calcul de son rapport et qu’il ne dispose pas de suffisamment d'informations pour déterminer les causes de ce ralentissement.

Autre point important du rapport, Epoch AI cite les causes qui pourraient obérer le développement des IA de pointe, notamment, la rareté des données, le montant des investissements, les restrictions en matière de consommation électrique des centres de données ou encore, l’impossibilité d’accroitre la production de processeurs spécialisés

dans l’IA.