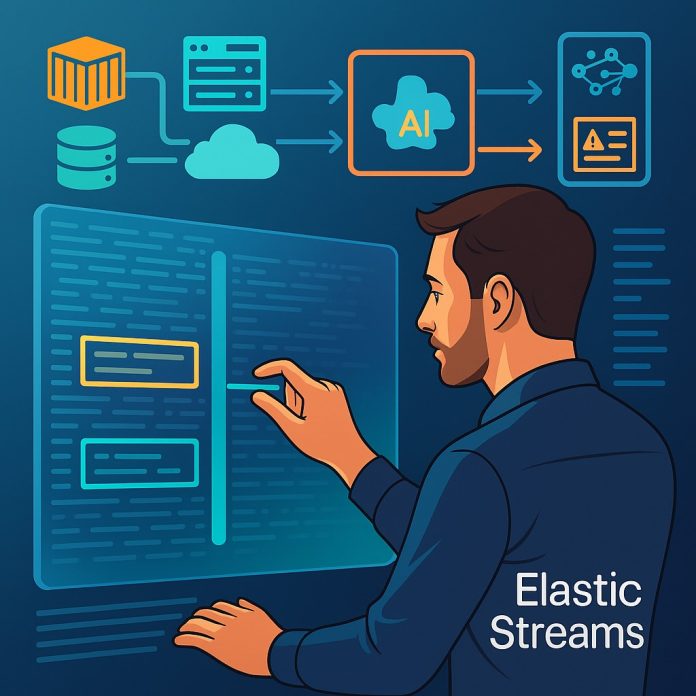

Elastic déploie Streams, une capacité d’observabilité appuyée sur l’intelligence artificielle pour transformer le traitement des journaux d’événements. L’éditeur repositionne les logs comme socle d’analyse, avec l’ambition de simplifier les investigations et de réduire les angles morts dans les systèmes distribués.

Elastic renouvelle son approche de l’observabilité en mettant en avant les journaux d’événements, longtemps sous-exploités malgré leur richesse informationnelle. Sa nouvelle solution, baptisée Streams, repose sur une ingestion unifiée et un traitement automatisé des flux de logs, qu’ils soient structurés ou non. L’intelligence artificielle identifie les événements significatifs directement dans ces flux, sans nécessiter de pipeline personnalisé ni de schéma prédéfini.

Les équipes de développement sont souvent confrontées à un paradoxe opérationnel stipulant que les métriques indiquent qu’un problème survient, les traces localisent la zone affectée, mais seules les lignes de journal permettent d’en comprendre l’origine. Elastic cherche à revaloriser ce levier en éliminant les obstacles techniques qui freinent son exploitation. Le traitement unifié des données brutes permet d’accélérer l’identification des causes profondes et de réduire la dépendance aux configurations complexes.

Des flux de journaux unifiés pour une visibilité étendue

La solution Streams se décline aujourd’hui en deux modes. Le premier, déjà disponible dans la version 9.2 d’Elastic, permet d’exploiter des journaux indexés pour faire émerger automatiquement des signaux pertinents. Le second mode, actuellement en préversion, prend la forme d’un point d’entrée direct pour ingérer les logs dès leur émission, sans traitement préalable. Cette capacité simplifie l’exploitation de données issues de sources multiples dans les environnements hybrides ou cloud natifs.

Les premiers retours d’usage mettent en évidence une réduction des volumes stockés sans perte de contexte, une meilleure identification des événements anormaux et un recentrage des équipes sur l’analyse, plutôt que sur la maintenance des pipelines. Cette orientation s’insère dans un contexte de surcharge informationnelle où les architectures conteneurisées génèrent une quantité exponentielle de signaux difficilement corrélables.

Les journaux d’événements replacés au centre de l’analyse

Elastic défend une approche où les logs ne sont plus considérés comme des résidus bruyants, mais comme la source d’information la plus explicite pour comprendre les comportements du système. Dans les articles publiés par les équipes produit, les auteurs soulignent que les journaux expliquent ce qui s’est réellement produit, là où les métriques et les traces restent indicatives. Cette conception réoriente la hiérarchie des signaux en observabilité, avec une lecture plus narrative et moins fragmentaire.

La feuille de route prévoit d’enrichir cette logique par des corrélations automatisées entre signaux, la génération d’alertes contextualisées, des pistes de remédiation opérationnelles et l’intégration de séquences d’actions automatisées. Ces éléments composent une orchestration intelligente des incidents, avec un système d’analyse plus fluide et plus réactif, en complément des outils d’AIOps traditionnels.

Des performances à valider dans les environnements hétérogènes

La robustesse du parsing automatisé et la pertinence des événements détectés feront l’objet d’une attention particulière dans les déploiements en production. L’efficacité des mécanismes d’apprentissage sur des jeux de données non homogènes, la réduction des faux positifs et la gestion des priorités conditionneront la confiance des équipes SRE. De même, l’interconnexion avec les agents de télémétrie existants, les collecteurs standards comme OpenTelemetry et les systèmes de sécurité intégrés s’avère essentielle pour éviter un écosystème fermé.

Dans les environnements à forte densité applicative, cette capacité à traiter les signaux à la source, sans générer de surcharge, devient un facteur différenciant. Elle renforce la lisibilité des phénomènes rares ou intermittents, tout en limitant la dilution de l’information dans des volumes croissants. Pour les organisations ayant besoin d’une observabilité exhaustive, cette approche pourrait structurer un nouveau standard autour d’un signal unique enrichi, interprété et activable.

Un repositionnement stratégique dans un marché sous tension

Elastic engage ici une inflexion stratégique en se démarquant d’une approche trop métrique ou trop dépendante des tableaux de bord segmentés. Cette vision entre néanmoins en concurrence avec d’autres acteurs bien établis, comme Datadog ou Splunk, qui développent également des offres enrichies par l’IA, avec ingestion directe et détection intelligente. La bataille se jouera autant sur l’intégration que sur la capacité à produire des résultats tangibles dans les délais les plus courts.

Pour les entreprises, les administrations et les fournisseurs de services, cette évolution propose une alternative à la fragmentation des outils, avec à la clé une meilleure compréhension des incidents, une diminution des zones aveugles et une réduction des délais de remédiation. L’émergence de signaux exploitables directement depuis les logs ouvre la voie à une observabilité plus fine, plus contextuelle et plus alignée avec les enjeux opérationnels.