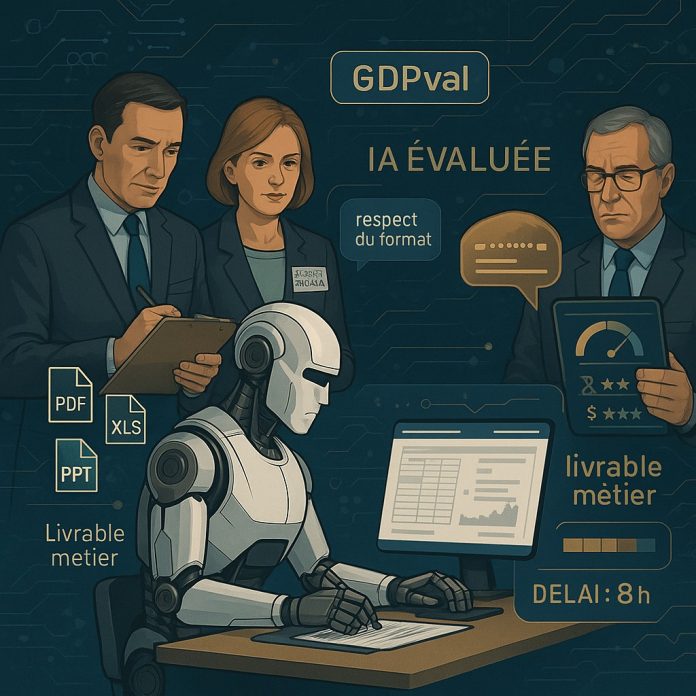

Avec GDPval, OpenAI confronte ses modèles à un test inédit : reproduire, à qualité égale, le travail de 44 métiers du tertiaire. Il s’agit pour le fournisseur de LLM de mesurer concrètement la valeur ajoutée des IA génératives sur des tâches longues, complexes et économiquement valorisables. Le verdict est nuancé, mais riche d’enseignements pour les entreprises.

Combien de temps, d’effort une IA peut-elle économiser lorsqu’elle se substitue — ou s’agrège — à un professionnel ? Pour le mesurer, OpenAI a lancé GDPval, un benchmark d’un nouveau genre, fondé non sur des questionnaires ou des raisonnements académiques, mais sur la production de livrables dans 44 métiers identifiés comme contributeurs majeurs au PIB. L’approche se veut ambitieuse, rigoureuse, et plus proche des réalités économiques que les tests traditionnels. Mais elle suscite aussi des débats méthodologiques : spécificité culturelle, tâches non interactives, reconnaissance implicite des styles de modèles… GDPval n’échappe pas à la controverse. Il n’en représente pas moins une trajectoire structurante vers l’évaluation industrielle des modèles d’IA.

Conçu comme un jeu d’essai, GDPval agrège 1 320 tâches issues de 44 métiers répartis sur les neuf principaux secteurs contributeurs au PIB des États-Unis, et validés par la Réserve fédérale de Saint-Louis. Les métiers ont été choisis en croisant trois critères : leur poids en masse salariale, leur caractère numérique, et leur représentativité dans le secteur. Pour chacun d’eux, OpenAI a recruté des experts métier, avec en moyenne 14 années d’expérience, chargés de concevoir des tâches authentiques, basées sur leur propre pratique professionnelle.

220 tâches pour des livrables métier

Parmi les 1 320 tâches développées pour le benchmark, OpenAI a isolé un sous-ensemble rigoureusement sélectionné de 220 cas baptisé l’échantillon « gold ». Ces tâches ont été choisies pour leur représentativité sectorielle, leur niveau de qualité validé, et leur capacité à illustrer des livrables concrets, réalistes et évaluables. Chacune a été soumise à un processus d’itération rigoureux : création par un expert métier, relectures croisées, anonymisation, puis évaluation comparative. C’est sur cet échantillon « gold » que reposent les principales mesures de performance des modèles d’IA, notamment les comparaisons à l’aveugle entre livrables humains et générés.

Chaque tâche associe une demande contextualisée, parfois accompagnée de fichiers de référence (jusqu’à 38), et un livrable à produire sous une forme libre (document, présentation, tableur, support audiovisuel, etc.). Le temps moyen estimé pour réaliser une tâche dans l’échantillon « gold » est de 9,5 heures, pour une valorisation médiane de 175 dollars. Le niveau de difficulté et de réalisme a été soigneusement validé par plusieurs tours de relecture, avec un total moyen de cinq évaluations humaines par tâche.

Les modèles s’améliorent… mais peinent à égaler les experts

OpenAI a soumis les tâches à plusieurs modèles dits de « frontière » : GPT-4o, GPT-5, Claude Opus 4.1, Gemini 2.5 Pro et Grok 4. Les réponses ont été évaluées à l’aveugle par des experts de chaque métier, en comparaison directe avec le livrable humain initial. Claude s’est montré supérieur sur la forme (mise en page, esthétique, lisibilité), tandis que GPT-5 s’est distingué par sa rigueur dans le respect des consignes et les calculs. Aucun modèle n’a dépassé les 48 % de livrables considérés comme équivalents ou supérieurs à ceux de l’expert humain.

Les limites sont connues : mauvaise interprétation des consignes, hallucinations, erreurs de format, livrables partiels… Les modèles échouent encore à comprendre les contextes implicites, à formuler des réponses adaptées à des destinataires variés, ou à maintenir une qualité constante sur des projets longs. Sur les prompts volontairement sous-spécifiés, les performances chutent de façon significative, révélant une difficulté persistante à gérer l’ambiguïté, pourtant omniprésente dans le travail réel.

Économie de temps, pas toujours d’effort : des gains modérés

L’un des apports majeurs de GDPval est d’estimer les gains réels en coût et en temps qu’un professionnel peut espérer en intégrant un modèle d’IA dans son flux de travail. L’étude explore différents scénarios — usage direct, usage avec revue humaine, usage par itérations avec retouches humaines… Les gains en productivité dépendent largement de la capacité du professionnel à guider le modèle, à réviser les sorties, et à arbitrer entre livrable imparfait et refonte manuelle.

Dans le scénario le plus réaliste (« essayer n fois, puis corriger soi-même »), GPT-5 permet de réduire le temps total passé (génération + relecture + correction éventuelle) d’un facteur 1,39 comparé à un expert humain réalisant seul la même tâche. Le coût total (temps d’usage du modèle + relecture humaine + éventuelle reprise manuelle) est 1,63 fois moins élevé par rapport à un expert humain faisait la tâche sans assistance. Ces résultats montrent que l’IA peut déjà jouer un rôle d’assistant structurant, mais que son exploitation efficace suppose une certaine expertise humaine — tant dans le prompt que dans l’évaluation critique du résultat. Les modèles peuvent accélérer certaines tâches, mais n’éliminent pas le besoin de supervision.

Entre rigueur méthodologique et angles morts

Si GDPval marque un tournant dans l’évaluation des modèles d’IA, on ne peut s’empêcher de nuancer sa portée. D’abord parce que les tâches, entièrement spécifiées en amont, ne simulent pas les échanges progressifs, ajustements contextuels ou reformulations itératives typiques du travail réel. Ce format statique favorise les modèles rigides, mais pénalise ceux conçus pour interagir ou contextualiser.

Ensuite, le benchmark ne tient pas compte d’un facteur pourtant central : la mémoire contextuelle. À l’heure où les modèles doivent composer avec des limites strictes de capacité à gérer de longues invites ou à croiser plusieurs sources en simultané, ignorer cet enjeu revient à masquer une contrainte technique majeure. De nombreuses erreurs relevées dans GDPval — oublis, incohérences, hallucinations — pourraient être attribuées non à une déficience de raisonnement, mais à une « sortie de la fenêtre contextuelle ». L’absence totale d’analyse sur ce point intrigue d’autant plus que la mémoire est aujourd’hui l’un des principaux leviers de différenciation entre modèles.

S’ajoutent d’autres biais structurels : sélection des métiers fortement nord-américains, reconnaissance implicite des styles de modèles lors des évaluations à l’aveugle, absence de pondération selon la gravité métier des erreurs, et pilotage intégral du benchmark par OpenAI. GDPval apporte une contribution précieuse à l’objectivation des usages IA, mais ne saurait être considéré comme un référentiel universel sans confrontation méthodologique ni pluralité d’approches indépendantes.

Un exemple pour piloter l’industrialisation des usages

Toutefois, bien qu’il laisse de côté des aspects importants, GDPval constitue un outil pédagogique de premier niveau pour les directions métiers, les DSI et les équipes IA qui cherchent à objectiver les cas d’usage. Dans le brouillard actuel concernant le ROI de l’IA, il permet de simuler l’impact de l’IA sur un portefeuille de tâches représentatif, d’identifier les goulets d’étranglement cognitifs, et de mesurer la maturité des modèles en condition proches du terrain. En combinant l’évaluation humaine, des prompts rigoureux, la multimodalité et les mesures économiques, il pose les bases des futurs standards de pilotage de l’IA en entreprise.

La démarche pourrait servir de modèle à d’autres secteurs, notamment en Europe, pour concevoir des référentiels d’évaluation propres aux contextes réglementaires, linguistiques ou métiers locaux. Elle appelle aussi à renforcer la formation des professionnels à la collaboration avec les agents IA, en intégrant des compétences de pilotage, de vérification, et de stratégie d’intégration. Car la valeur de l’IA ne réside pas seulement dans sa capacité à répondre, mais aussi, et surtout, dans notre capacité à la guider.