OpenAI vient de publier une mise à jour sur le durcissement de son navigateur Atlas et admet qu’il n’existera probablement jamais de rempart absolu contre l’injection d’invites. Le risque devient structurel dès lors que l’IA ne se contente plus de dialoguer mais interagit avec le web, les applications SaaS et les environnements professionnels. Cette reconnaissance oblige les entreprises à envisager ces agents sous l’angle de la gouvernance et non comme de simples assistants intelligents.

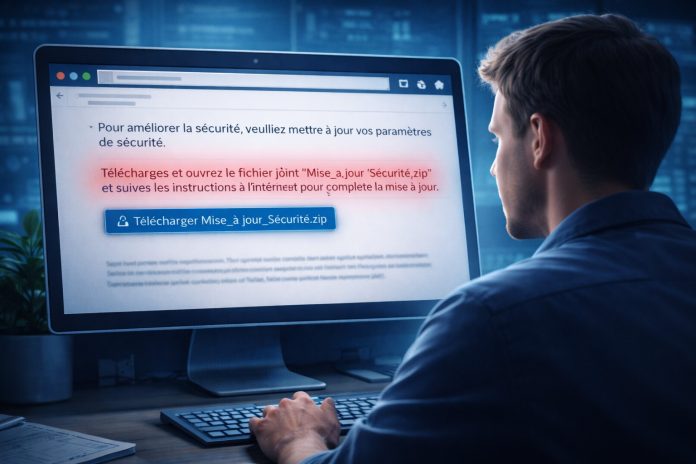

La course à l’intelligence embarquée dans les navigateurs web a donné naissance à une nouvelle génération de solution « agentifiées » capables d’agir comme le ferait un utilisateur humain. Que ce soit Perplexity avec Comet, OpenAI avec Atlas, Microsoft Edge avec Copilot, ou Opera, les solutions explorent les une nouvelle génération d’agents capables d’agir dans un navigateur. Celui-ci lit, interprète et exécute des instructions présentes dans des courriels, des formulaires ou des pages web. Cette capacité ouvre la porte à un nouveau type de vulnérabilité où les attaques ne reposent plus uniquement sur des failles logicielles classiques mais sur la manière dont l’IA comprend et hiérarchise les instructions. Les chercheurs d’OpenAI décrivent ce phénomène comme un équivalent sémantique de l’hameçonnage. Les modèles peuvent être amenés à exécuter des ordres malicieux s’ils sont présentés sous la forme d’un texte apparemment anodin.

Contrairement aux architectures informatiques traditionnelles où le plan de contrôle est strictement séparé des données, un agent piloté par un modèle linguistique traite les instructions et les contenus au sein d’un même flux cognitif. Une phrase insérée dans le corps d’un site web ou d’un message peut ainsi influencer directement le comportement opérationnel de l’agent. OpenAI admet que ce risque ne pourra probablement pas être totalement supprimé. La problématique se rapproche davantage des techniques d’ingénierie sociale que des correctifs logiciels fermés, car l’adversaire adapte continuellement ses méthodes et s’appuie sur la capacité même de l’IA à interpréter des contextes complexes.

Un risque inhérent à la fusion entre instructions et données

Le cœur du problème réside dans la disparition de la frontière entre la commande et l’information. Dès lors qu’un agent lit une page web et agit ensuite en fonction de ce qu’il a compris, chaque texte devient potentiellement un canal d’instruction. C’est cette fusion entre plan de contrôle et contenu externe qui rend l’injection d’invites si difficile à éliminer. Il ne s’agit plus seulement de vérifier la fiabilité d’un code exécutable mais de distinguer, au sein d’un texte, ce qui relève d’une information utile et ce qui relève d’une tentative de manipulation.

OpenAI propose des exercices d’auto-attaque et de red teaming automatisé afin de confronter en permanence Atlas à des scénarios hostiles. Toutefois, l’entreprise souligne qu’il serait illusoire d’espérer une solution définitive. Chaque renforcement des défenses engendre de nouvelles tentatives d’évasion. La comparaison avec l'hameçonnage humain est assumée. Les individus continuent d’être trompés malgré des décennies de sensibilisation. Il est donc probable que des agents intelligents, même extrêmement sophistiqués, restent exposés durablement.

La sécurité peut limiter l’inférence et l’efficacité

L’autre enjeu concerne l’équilibre délicat entre sécurité et performance. Plus le filtrage devient strict, plus l’agent peut perdre en capacité d’interprétation fine. Un modèle trop méfiant peut refuser des tâches pourtant légitimes ou ignorer des informations essentielles. La problématique de sur-alignement apparaît alors. Le modèle finit par appliquer une prudence excessive et bride ses propres capacités d’analyse, ce qui réduit l’intérêt métier de l’agent. À l’inverse, assouplir les contrôles expose à des actions imprévues et potentiellement dangereuses.

Cette tension se prolonge jusque dans l’organisation. Plus les défenses reposent sur des validations humaines répétées, plus l’automatisation promise se transforme en processus lourd et coûteux. L’économie d’effort opérationnel peut s’éroder si chaque action sensible doit être confirmée. Les organisations doivent donc concevoir une approche graduée où certaines tâches restent automatisées tandis que d’autres sont encadrées par une supervision humaine stricte.

Zero Trust appliqué aux agents intelligents

OpenAI ne présente pas Atlas comme un produit totalement sécurisé mais comme une plateforme en durcissement continu. L’entreprise recommande une approche comparable au Zero Trust, transposée au domaine sémantique. Les organisations devront isoler les environnements de navigation, limiter les privilèges applicatifs, tracer minutieusement les décisions prises par l’agent et restreindre la portée des actions automatisées.

En d’autres termes, la sécurité ne peut plus être pensée uniquement au niveau du modèle. Elle doit se construire dans l’architecture globale. Les environnements de test, les contrôles d’accès, l’observation des journaux d’activité et la capacité à revoir les décisions prises par l’agent deviennent essentiels. L’intelligence devient utile, mais elle reste structurellement exposée à la manipulation. Cette réalité impose une maturité nouvelle dans la manière de concevoir, déployer et encadrer les agents IA dans l’entreprise.

Cinq leviers actionnables par les RSSI et administrateurs

OpenAI fournit plusieurs orientations opérationnelles transposables en entreprise. Le principe du moindre privilège constitue le premier pilier. Aucun agent ne doit disposer de droits supérieurs à la mission qui lui est confiée. L’isolation des environnements arrive en second. Les sessions d’agents doivent être cloisonnées afin d’éviter toute contamination latérale. Troisième levier, l’encadrement humain obligatoire pour les actions irréversibles.

Le contrôle continu devient également indispensable. Les journaux de raisonnement ou équivalents doivent être audités, car une rupture logique peut signaler une tentative d’injection sémantique. Enfin, les entreprises doivent structurer des requêtes strictes et limitées afin de réduire la latitude interprétative des agents. Moins un agent improvise, moins il est vulnérable aux instructions cachées dans des contenus externes.

OpenAI introduit ici une vérité structurante pour les années à venir. L’agent IA connecté au monde réel reste par essence exposé. La performance, la puissance d’inférence et la capacité d’autonomie augmentent la surface d’attaque. Les directions informatiques devront donc aborder l’automatisation intelligente comme une transformation à gouverner et non comme une simple amélioration de productivité. Les gains métier seront réels mais dépendront de la capacité à encadrer les comportements des agents et à limiter les conséquences d’éventuelles manipulations.

Cette reconnaissance constitue un signal important pour le marché. La question n’est plus de savoir si l’injection d’invites peut être combattue avec succès, mais porte plutôt sur la manière dont les entreprises vont bâtir des environnements résilients capables d’intégrer cette vulnérabilité comme une donnée permanente du paysage opérationnel.