Au-delà du débat sur la violation des libertés publiques et des biais, c’est l’acuité même de la technologie de reconnaissance faciale qui a été prise en défaut par les chercheurs de McAfee. Suite à leur expérience, nous sommes en droit de poser la question : que valent vraiment les technologies de reconnaissance faciale ?

Aucune technologie n’est fiable à 100 % et toute nouvelle technologie porte en elle ses propres vulnérabilités, donc ses vecteurs d’attaque. Sachant cela, il n’est donc pas surprenant que des personnes déterminées et armées des connaissances et des outils adéquats peuvent contourner les plus sophistiquées des contre-mesures ou prendre en défaut la précision d’une technologie, la reconnaissance faciale dans le cas qui nous occupe.

C’est ce que viennent de démontrer des chercheurs de l’Advanced Threat Research (ATR) de chez McAfee, après bien d’autres qui se sont penchés sur la question. Contrairement aux autres recherches, notamment celles du MIT, les chercheurs de McAfee ne se sont pas attaqués, une énième fois, aux biais raciaux et sexistes. Non, ils ont délibérément trompé un système de reconnaissance faciale pour lui faire prendre une personne pour une autre (voir la vidéo à la fin de cet article). Les biais sont le résultat d’apprentissages, au mieux, incomplets, au pire, mal faits. Il peut aussi s’agir d’une algorithmie défaillante, un mauvais code en somme. Les biais peuvent donc être corrigés via un apprentissage inclusif et des corrections algorithmiques. La tromperie d'une IA est en revanche plus difficile à réaliser et à corriger.

Model hacking ou Adversarial Machine Learning

Ce dont il s’agit ici est une démonstration de la vulnérabilité des systèmes de reconnaissance faciale via un Adversarial Machine Learning. Plus connu sous le nom de Model hacking, l’AML consiste à trouver les failles dans des modèles d’intelligence artificielle pour contrer d’éventuelles attaques. Le modèle est formé en permanence pour comprendre les nouvelles menaces et s’assurer que le système peut se défendre contre les attaques actuelles et futures.

Suivant le principe de l’AML, l’équipe de chercheurs de McAfee a réussi à tromper le système en lui faisant reconnaitre une personne pour une autre. L’expérience a été menée contre un système de reconnaissance faciale similaire à ceux utilisés actuellement dans les aéroports pour la vérification des passeports, et monté de toutes pièces par les chercheurs.

GAN ou auto-apprentissage par essai et erreur

En utilisant l’apprentissage automatique via la technologie GAN (Generative Adversarial Network), ils ont créé une image qui ressemblait à une personne, mais qui a été identifiée comme quelqu’un d’autre par l’algorithme de reconnaissance faciale. Plus précisément, ils ont utilisé l’algorithme de traduction d’images CycleGAN, qui transforme des images d’un style à un autre. Il peut par exemple transformer la photo d’un paysage en tableau peint dans un certain style, impressionniste par exemple, avec un réalisme difficilement discernable par l’œil humain.

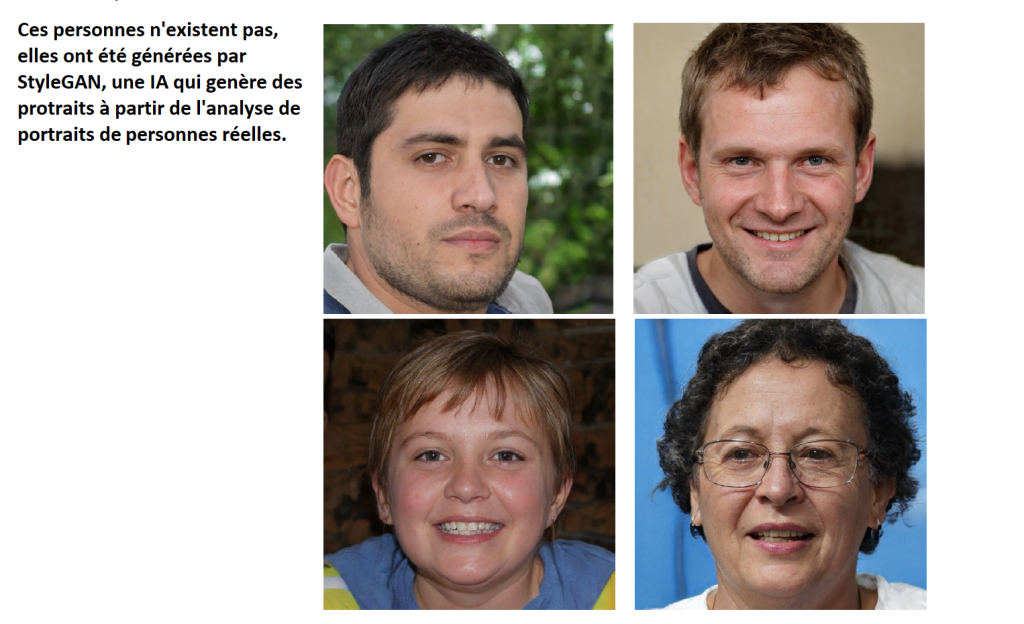

Le concept de GAN ou Generative Adversarial Network est une méthode de plus en plus reconnue dans le domaine des sciences des données. Il permet de faire travailler l’IA de manière contradictoire : un générateur travaillant en tandem avec un ou plusieurs discriminateurs. Le premier crée un portrait et le second doit déterminer si ce portrait est celui d’une personne réelle ou pas. Si la réponse du discriminateur est négative, le générateur recommence en modifiant ce qui ne va pas et ainsi de suite jusqu’à ce que le discriminateur soit satisfait. C’est comme un expert en art et un faussaire : le second doit tromper le premier en se rapprochant le plus possible de la réalité. En procédant de la sorte, la production finale s’approche du réalisme, comme dans les images ci-dessus.

Un POC pour prendre conscience des failles de l’IA

Dans le cas de McAfee, le défi était de tromper l’IA en lui faisant croire qu’une personne, disons le sujet A, est une autre, le sujet B. Cependant, il fallait créer une image qui ressemble au sujet A afin de passer les contrôles humains. C’est là que se niche la subtilité de cette

« arnaque » : la même photo, vue par un humain sera identifiée comme le sujet A, mais identifiée comme le sujet B par le système de reconnaissance faciale. Cela revient à tromper le système pour permettre à quelqu’un de monter à bord d’un vol ou passer des frontières sans en avoir l’autorisation.

Bien entendu, ce genre d’attaque n’est pas à la portée du premier venu. En pratique, elle nécessite d’infiltrer le système en se plaçant entre la caméra et l’application de reconnaissance faciale afin de tromper celle-ci. En somme, ça revient à installer une black box quelque part dans le circuit afin d'alimenter l'IA en images "bidouillées". Cela semble simple à faire, mais c’est là où commencent les difficultés, car il faut connaître les modèles utilisés par l’IA. L’attaquant doit connaître chaque caractéristique, chaque ligne de code presque, chaque entrée et sortie, pour prédire comment un modèle va classer la fausse information qui lui sera soumise. L’expérience de l’ATR de McAfee est en réalité un POC destiné à attirer l’attention sur les failles des systèmes de reconnaissance faciale. Ses chercheurs se disent prêts à travailler avec les agences gouvernementales et les entreprises technologiques pour trouver une parade.

« La biométrie est une technologie de plus en plus utilisée pour authentifier ou vérifier les personnes et remplace efficacement les mots de passe et autres méthodes d’authentification potentiellement peu fiables dans de nombreux cas. Toutefois, le recours à des systèmes automatisés et à l’apprentissage machine sans tenir compte des failles de sécurité inhérentes aux mystérieuses mécaniques internes des modèles de reconnaissance de façade pourrait donner aux cybercriminels des capacités uniques pour contourner les systèmes critiques », avertissent les chercheurs dans leur rapport.