À l’occasion de son événement annuel, AWS a dévoilé la puce Trainium3 UltraServers pour l’entraînement et l’inférence des modèles d’intelligence artificielle. Ce lancement marque une étape stratégique dans un marché marqué par la pénurie de puces pour la généralisation de l’IA. Trainium3 combine un saut de performance, une efficacité énergétique renforcée et des capacités d’agrégation.

La deuxième journée de la conférence AWS re : Invent 2025 s’est ouverte à Las Vegas sur une série d’annonces, pilotées par Matt Garman, CEO d’AWS. Cette édition 2025 consacre l’accélération du marché de l’IA généralisée. Les annonces couvrent à la fois l’émergence d’agents IA de nouvelle génération, l’industrialisation des infrastructures avec AWS AI Factories et la popularisation du développement IA à grande échelle. Au centre de ce dispositif, la nouvelle puce Trainium3 UltraServers permet à l’hyperscaler de proposer de nouvelles capacités pour l’entraînement et l’inférence des modèles IA de très grande taille, en conjuguant puissance, maîtrise des coûts et réduction de l’empreinte carbone.

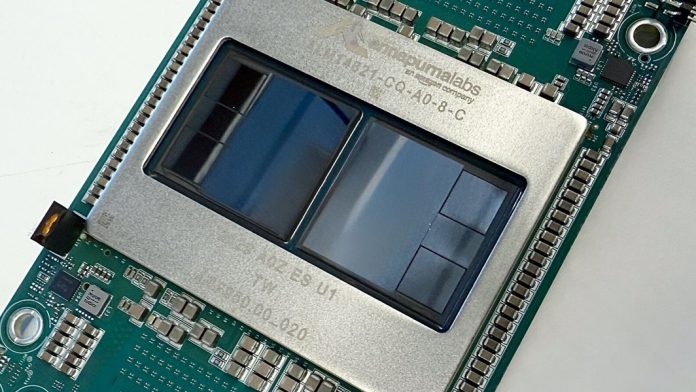

La puce Trainium3 UltraServers incarne la volonté d’AWS de proposer une plateforme matérielle taillée pour les nouveaux besoins de l’IA générative et des applications industrielles. Chaque puce fournit jusqu’à 2,52 pétaflops de calcul en précision FP8, associée à 144 Go de mémoire HBM3e bénéficiant d’une bande passante de 4,9 To/s. La modularité de l’offre permet d’agréger jusqu’à 144 puces dans un même UltraServer, totalisant 362 Pflops et 20,7 To de mémoire à bande passante allant jusqu’à 706 To/s.

Un socle d’industrialisation de l’entraînement des IA géantes

Selon AWS, la génération Trainium3 délivre ainsi 4,4 fois plus de puissance de calcul et quatre fois plus d’efficacité énergétique que la génération précédente, tout en multipliant par quatre la bande passante mémoire. Ce gain de densité s’appuie sur une interconnexion réseau interne NeuronSwitch-v1/NeuronLink-v4, qui double la bande passante interpuces et favorise l’entraînement distribué des modèles volumineux, enjeu crucial de l’IA contemporaine.

Avec Trainium3 UltraServers, AWS vise le marché des acteurs confrontés à la complexification des modèles IA, tant pour l’entraînement que pour l’inférence à grande échelle. Le recours à une mémoire HBM3e sur chaque puce (144 Go à 4,9 To/s) répond aux besoins croissants d’accès rapide et simultané à des ensembles de données massifs. L’architecture permet, selon AWS, de fédérer jusqu’à 144 puces, pour constituer des clusters de calcul atteignant 20,7 To de mémoire globale et 706 To/s de bande passante. Cette approche favorise l’optimisation du débit de données, la réduction de la latence et l’adaptation dynamique des charges de travail en fonction des modèles.

Le rapport performance/efficacité énergétique est l’un des atouts revendiqués par AWS. La Trainium3 promet de réduire significativement le coût par modèle, en mobilisant un niveau de performance compatible avec l’entraînement des architectures IA géantes. La nouvelle interconnexion NeuronSwitch-v1/NeuronLink-v4 accélère la synchronisation des calculs entre puces, tout en maintenant une faible latence. Pour les développeurs, l’intégration native avec Amazon Bedrock AgentCore garantit la continuité du service, tandis que les nouvelles capacités de Nova 2, Nova Forge et Nova Act facilitent la gestion, l’optimisation et le test des modèles sur des environnements industrialisés.

Une chaîne logicielle optimisée pour Trainium3

En complément du hardware, l’annonce officialise l’arrivée de la génération Nova 2 et l’extension de l’écosystème logiciel autour de Nova Forge et Nova Act. Ces solutions industrialisent le cycle de vie des modèles IA, du développement à la production, en tirant pleinement parti des capacités de calcul et de mémoire offertes par la plateforme Trainium3. Nova Forge, en particulier, permet d’automatiser l’optimisation des modèles et de réduire les délais de mise en production, tandis que Nova Act se concentre sur la gouvernance, l’analyse et l’évaluation des performances en production.

Les nouveaux agents IA « Frontiers » symbolisent cette orientation vers l’automatisation intelligente du développement logiciel. En s’appuyant sur Trainium3 et Nova, ces agents accompagnent les développeurs dans la génération de code, l’analyse de performances et la détection d’anomalies. L’objectif est de raccourcir le cycle tout en fiabilisant les applications IA déployées à grande échelle.

AWS AI Factories : industrialiser et démocratiser l’IA

L’annonce des AWS AI Factories présente une offre intégrée pour transformer les centres de données en véritables usines d’IA, en combinant la puissance des UltraServers Trainium3, la suite logicielle Nova et les outils d’automatisation pour proposer un environnement unifié. Cette industrialisation repose sur une double promesse : abaisser la barrière à l’entrée pour les entreprises tout en optimisant les coûts, la flexibilité et la consommation énergétique. Pour Matt Garman, cette nouvelle génération d’infrastructures prépare l’avènement d’une IA accessible, industrielle et pilotée par les usages, à la croisée de la performance technologique et de la maîtrise opérationnelle.

La rivalité autour des puces spécialisées pour l’entraînement et l’inférence de l’intelligence artificielle ne relève pas d’un simple enjeu d’innovation : elle traduit une véritable bataille industrielle pour le contrôle de la ressource la plus stratégique du moment. La pénurie chronique de processeurs dédiés, qu’il s’agisse de GPU, de NPU ou de solutions maison comme Trainium3, fragilise l’ensemble de la chaîne de valeur de l’IA, depuis les concepteurs de modèles jusqu’aux fournisseurs de plateformes cloud. Cette tension suscite un vif appétit chez les acteurs dont le modèle d’affaires repose sur la capacité à absorber ou à servir une demande en explosion : éditeurs de logiciels, géants du numérique, entreprises de services et même start-up innovantes sont en compétition pour sécuriser leur accès à ces infrastructures. Cette course n’a rien d’anecdotique au moment où la plupart des innovations IA dépendent d’un accès fluide et massif à la puissance de calcul.

La pénurie alimente la concentration, la verticalisation et l’intégration des offres, tandis que chaque acteur cherche à renforcer sa capacité technique. Elle est bien le moteur principal de la compétition entre les grands acteurs, chacun cherchant à sécuriser l’accès à la ressource-clé qui conditionne la croissance future de l’IA.